Alcuni anni fa, quando la maggior parte di noi aveva monitor con risoluzione 1024 x 768 o addirittura 1280 x 1024 pixel, i produttori ci dicevano che sembrava sfocato e che per avere la migliore qualità dell'immagine dovevamo passare a Risoluzione Full HD (1920 x 1080). Ora il 4K è sulla bocca di tutti, si scopre che è Full HD che sembra sfocato e che dobbiamo acquistare un monitor ad alta risoluzione avere il migliore qualità dell'immagine . Fino a che punto è vero?

Di solito possiamo pensare a questa come una strategia di marketing, ed è proprio così: hanno creato monitor migliori e vogliono venderli, quindi ci dicono che quello che abbiamo ora non ne vale la pena e che dobbiamo spendere soldi per il loro nuovo prodotto. Ma, in realtà, stiamo anche migliorando la qualità dell'immagine ... o no?

Una risoluzione più alta significa una migliore qualità dell'immagine?

Se ci atteniamo ai dati empirici, uno schermo Full HD ha 1920 x 1080 pixel, o qual è lo stesso, poco più di 2 milioni di pixel. Un display Ultra HD ha una risoluzione di 3840 x 2160 pixel, circa 8.3 milioni di pixel, quattro volte di più. Ciò significa che nello stesso spazio stiamo integrando molti più pixel, quindi ciò che avremo è un file definizione più alta , purché si parli della stessa dimensione dello schermo.

E questa è un'informazione importante, la dimensione dello schermo, perché ciò che ci dà definizione non è la risoluzione o il numero di pixel, ma la densità dei pixel.

La densità dei pixel è il fattore chiave per la definizione

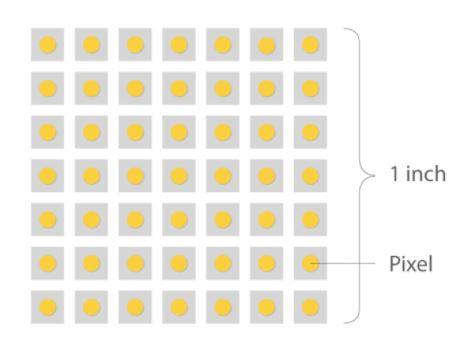

La densità dei pixel in un monitor è misurata in punti per pollice (DPI in inglese per "punti per pollice") ma poiché si riferisce al numero di punti che si trovano all'interno di una linea di un pollice di scansione, sono stati interrotti a favore di PPI (pixel per pollice). Sebbene PPI sia il termine corretto per riferirsi ai monitor, i due sono spesso usati in modo intercambiabile.

La densità dei pixel è importante perché è ciò che determina la qualità dell'immagine, nel senso che, in generale, una densità maggiore creerà immagini più nitide. Facciamo alcuni esempi prendendo come riferimento un monitor da 27 pollici, che oggi è abbastanza comune e normale:

- Un monitor 27p da 720 pollici avrebbe circa 54 PPI.

- Un monitor 27p da 1080 pollici ha una densità di circa 81 PPI.

- Se il monitor ha una risoluzione di 1440p, la sua densità sarebbe di circa 108 PPI.

- Se andiamo alla risoluzione 4K, la densità sale a 163 PPI.

- Un monitor 27K da 8 pollici avrebbe una densità di 326 PPI.

Per mettere questi dati in prospettiva, immagina di avere due monitor, uno accanto all'altro ed entrambi con risoluzione Full HD. Se uno di loro ha una dimensione di 32 pollici mentre l'altro è di 27 pollici, se ingrandisci noterai un'evidente differenza in termini di dimensione dei pixel, poiché sebbene entrambi i monitor abbiano la stessa quantità, la densità del 27 pollici saranno molto più grandi, i suoi pixel saranno più piccoli e quindi fornirà una migliore definizione.

Un altro esempio quando si parla di densità: immagina un monitor 1000K da 4 pollici (esagerando). Stando così le cose, vedremo che i pixel hanno una dimensione considerevole perché la densità sarebbe molto bassa, e quindi la qualità dell'immagine sarà pessima indipendentemente da quanto 4K sia.

Quindi maggiore è la densità dei pixel, meglio è?

La risposta è sì e no. In generale, una densità di pixel più alta è migliore perché fornisce una migliore definizione dell'immagine, ma c'è un certo punto in cui le prestazioni diminuiscono. Man mano che la densità aumenta sempre di più, i vantaggi osservabili di quella densità più elevata sono sempre meno evidenti al punto che sono impercettibili all'occhio umano.

Nell'esempio sopra, il monitor Full HD da 27 pollici avrà una densità di circa 81 PPI, mentre il monitor da 32 pollici avrà 69 PPI. In questa situazione è lecito affermare che ci saranno differenze osservabili tra i due monitor, ma se stessimo parlando di due monitor da 24 pollici, entrambi, uno con risoluzione 4K e l'altro 8K, la differenza sarebbe impercettibile, e tuttavia, ovviamente, l'elaborazione delle immagini con risoluzione 8K ha un costo in termini di prestazioni molto più elevato rispetto a farlo a 4K.

A questo punto, il punto esatto di densità in cui l'occhio umano smette di percepire i cambiamenti è in discussione. Alcuni esperti dicono che questa cifra è di circa 400 PPI, altri dicono 1000 e la maggior parte degli utenti si accontenta anche di meno di 200. Qualunque sia il punto, ciò che è evidente è che arriva un certo punto nel tempo. che una maggiore densità di pixel non è più apprezzata.

Qualità dell'immagine, legata ma non legata alla risoluzione

Tornando all'argomento principale, secondo Dolby, la qualità dell'immagine che le persone percepiscono (perché in fondo è una questione soggettiva di percezione) dipende principalmente da tre fattori:

- Il numero di pixel (e la loro densità, come abbiamo spiegato).

- La velocità di fotogrammi al secondo.

- Le prestazioni dei pixel.

È su quest'ultimo punto che i produttori di pannelli monitor hanno sottolineato negli ultimi tempi, poiché -secondo Dolby- se si ottiene che anche a parità di pixel questi siano in grado di rappresentare una gamma dinamica maggiore e con uno spazio colore maggiore , la qualità di riproduzione è migliorata. E per quanto ci riguarda, non potremmo essere più d'accordo, dato che non tutto è risoluzione quando parliamo di qualità dell'immagine ma in termini di user experience, FPS e tecnologie associate, come l'HDR ad esempio, influiscono notevolmente. .