V současné době se většina útoků namířených proti systémům umělé inteligence (AI) zaměřuje na jejich manipulaci. Systémy doporučení se tak například snaží upřednostňovat konkrétní obsah místo toho, co by mu legitimně odpovídalo. Kyberzločinci nyní využívají výhod těchto typů útoků pomocí strojového učení (ML) a byly popsány v matici hrozeb.

Podle Microsoft, útoky na systémy strojového učení (ML) jsou roste kousek po kousku . Kromě toho společnost MITER poznamenává, že v posledních třech letech došlo k ohrožení jejich systémů ML u velkých společností, jako jsou Microsoft, Google, Amazon a Tesla. V tomto smyslu nemá většina organizací správná řešení pro ochranu svých systémů strojového učení a hledá pokyny, jak to udělat.

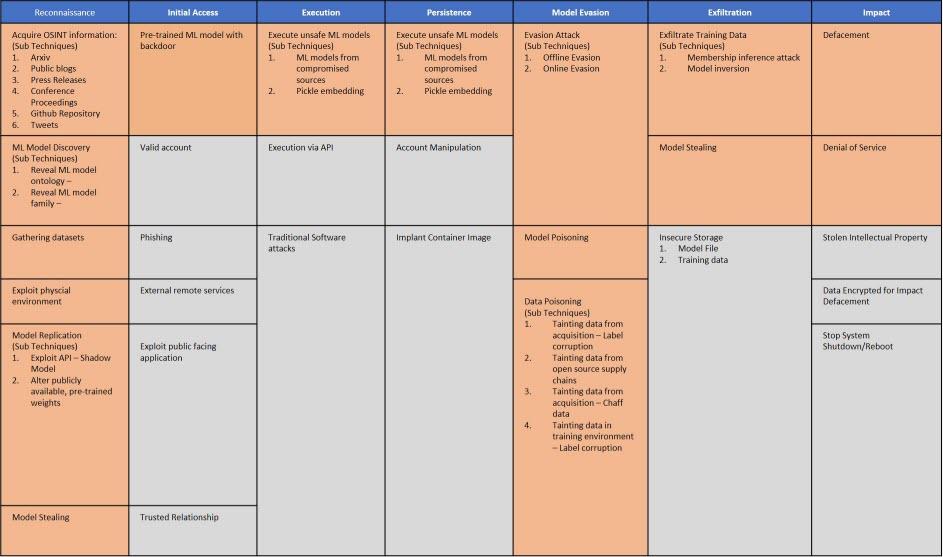

Odborníci z Microsoft, MITER, IBM, NVIDIA, University of Toronto, Berryville Institute of Machine Learning spolu s dalšími společnostmi a organizacemi, vytvořily první verzi Matice hrozeb Adversarial ML . Jeho cílem je vytvořit matici hrozeb, která pomůže bezpečnostním analytikům detekovat a reagovat na tyto typy útoků.

Umělá inteligence jako metoda provádění útoků

Umělá inteligence je zdroj, který se stále více používá k infikování počítačů, krádeži informací a ohrožení bezpečnosti. Jednou z technik, ve které můžeme použít umělou inteligenci a strojové učení, je otrava dat.

Tento útok je určen k manipulaci s tréninkovou datovou sadou pro ovládání prediktivního chování. Cílem je jeho nefunkčnost a dodržování podmínek útočníka. Tímto způsobem můžete klasifikovat nevyžádané e-maily jako vhodný obsah a dostanou se do naší doručené pošty. Zde je příklad toho, jak umělá inteligence se používá v kybernetických útocích .

Strojové učení a zabezpečení

Strojové učení, které vychází z ML (Machine Learning), je odvětví umělé inteligence, jehož cílem je vyvinout techniky, které počítačům umožní autonomní učení. Výzkumníci v oblasti strojového učení hledají algoritmy pro převod vzorků dat do počítačových programů, aniž by je museli psát. Výsledné programy tedy musí být schopné generalizovat chování, předpovídat, rozhodovat nebo klasifikovat věci s přesností.

Mikel Rodríguez, výzkumný pracovník strojového učení ve společnosti MITER, uvedl, že jsme nyní ve stejné fázi s AI, jako jsme byli s internetem na konci 1980. let. V té době byl internet navržen tak, aby fungoval, a nebyl zamýšlen jako samostatný. zabezpečení ke zmírnění možných útoků.

Z této chyby se však můžete poučit, a proto byla vytvořena Adversarial ML Threat Matrix. Toho, čeho má být dosaženo, je, že tato matice pomáhá uvažovat holisticky a bude stimulovat lepší komunikaci. Je tedy zamýšleno podporovat spolupráci mezi organizacemi poskytnutím společného jazyka různých zranitelností.

Co nám poskytuje matice hrozeb ML protivníka

Díky této matici hrozeb mohou správci zabezpečení pracovat s modely založenými na skutečných událostech, které pomocí strojového učení napodobují chování protivníka. K vytvoření matice použili ATT & CK jako šablonu, protože bezpečnostní analytici jsou obeznámeni s používáním tohoto typu matice.

V matici hrozeb máme různé fáze útoku, například: rozpoznání, počáteční přístup, provedení, vytrvalost, únik, exfiltrace a dopad. Tímto způsobem ve druhé fázi počátečního přístupu najdeme Phishing útoku, o kterém se tolik mluví. Pokud se chcete dozvědět více informací o popisu fází Adversarial ML Matrix, zde je tento odkaz.

Je třeba mít na paměti důležitý fakt, že matice hrozeb není rámcem prioritizace rizik a kompiluje pouze známé techniky. Dále se ukázalo, že matici lze přiřadit útoky. Nakonec bude matice hrozeb pravidelně aktualizována, jakmile bude přijata zpětná vazba od komunity strojového učení zabezpečení a protivníků. Chtějí také povzbudit spolupracovníky, aby poukazovali na nové techniky, navrhovali osvědčené postupy a sdíleli příklady úspěšných útoků.