HBM内存因在某些图形卡中用作VRAM内存而闻名,但我们开始关注的要点之一是服务器CPU中的HBM内存。 原因? 目的不是将HBM存储器挂载为 内存 内存,但是LLC或上一级缓存,以加快某些作业的速度。

迄今为止,与HPC市场的GPU相关的HBM内存将开始被CPU采用。 它带来了什么以及为什么将HBM内存用于CPU以及什么是 英特尔 和 AMD公司实施它的原因是什么?

HBM记忆回顾

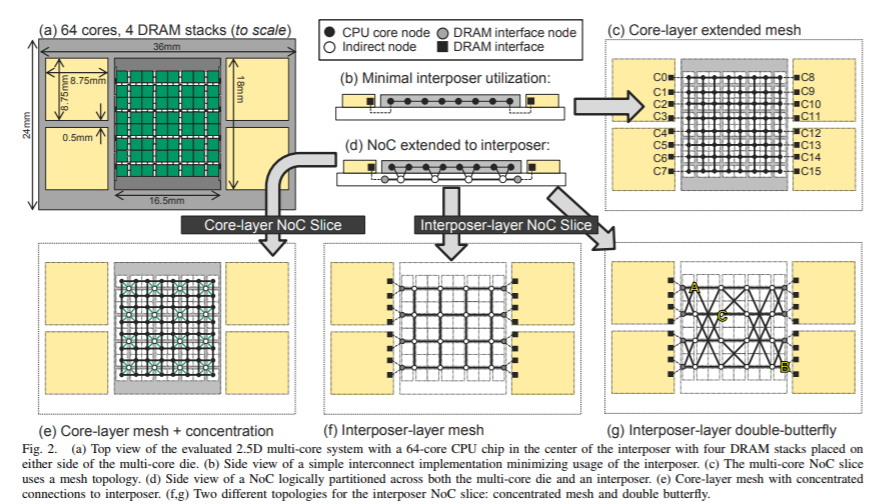

HBM存储器是一种由几个堆叠的存储器芯片组成的存储器,这些存储器芯片使用通过硅的路径与您的控制器进行垂直通信。 这种三维集成电路被封装在一起并作为HBM芯片出售。

为了与处理器通信,HBM芯片不使用串行接口,而是与下面的基板或中介层通信以传输数据。 这使您可以使用更多数量的针脚与处理器进行通信,并降低每个针脚的时钟速度。 结果? 与另一种类型的RAM存储器相比,在传输数据时消耗少得多。

HBM内存价格昂贵,尚未在国内市场使用,它由多个内存芯片组成,很难为大规模产品制造,但对于较小规模的产品来说是理想的选择。 无论是用于高性能计算的GPU,还是用于HBM即将出现的服务器的CPU,

内存通道是关键

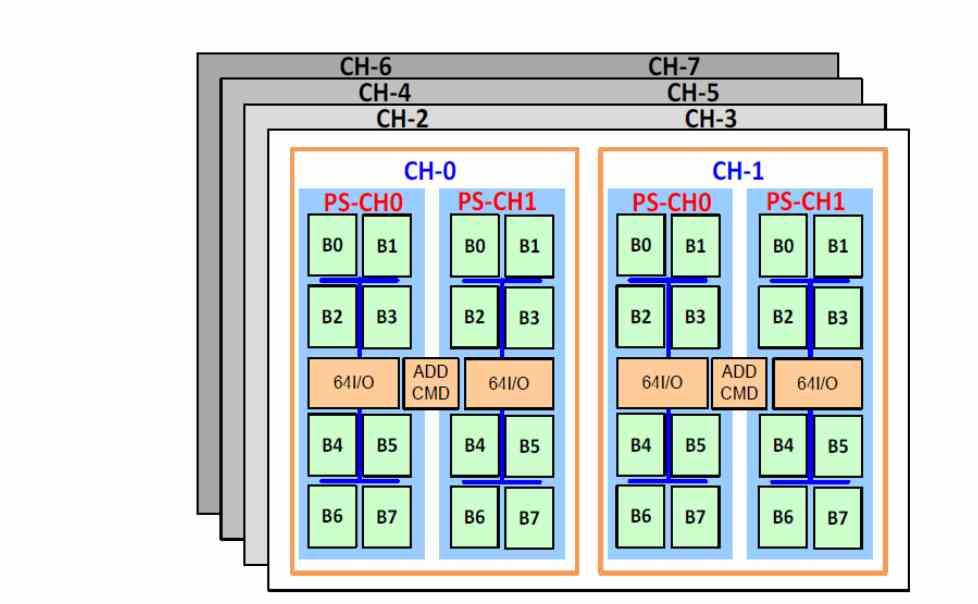

HBM内存与其他类型的内存的区别之一是最多支持8个内存通道,这是服务器中通常使用的配置。 因此,DDR8存储器的4个通道被HBM存储器的8个通道所取代,后者具有更高的带宽和更低的延迟。

较低的延迟? 好吧,是的,所有这些都是由于位于同一基板上,因此这意味着在执行指令期间访问存储器的时间更少,因此延迟也更短。 障碍? HBM2存储器的存储容量要小得多,因此有必要将存储器添加到层次结构的较低级别。

由于它的延迟比DDR4低,因此可以将HBM用作存储器的内存。 中央处理器 在内存层次结构中位于DDR4内存上方的位置,并且根据需要将数据从DDR4转储到HBM内存,甚至使用NVMe SSD 具有足够快的PCI Express接口的内存。 当然,使用从SSD到RAM的实时数据压缩和解压缩系统。

服务器CPU需要HBM存储器做什么?

HBM内存因其巨大的带宽而特别引人注目,这对于CPU来说似乎完全是夸张的,但是必须考虑到以下几点: NVIDIA公司 自Volta推出以来,由于在GPU中增加了张量单元,因此在服务器市场中占有很大份额的是人工智能,因此用于人工智能训练和推理的绝大多数系统都包括此类单元。

英特尔和AMD的情况如何? 答案是在服务器中添加这种类型的单元,在Intel中,它们是AMX单元,而在AMD中,目前尚不清楚它们将要实现的单元。 但是添加这些驱动器的目的是减少服务器的NVIDIA硬件。 为此,我们必须牢记AMD拥有一个与NVIDIA竞争的图形部门,但我们也不能忘记Intel的Intel Xe HPC和Intel Xe HP。

用于AI的单元需要大量带宽才能工作,因为它们与GPU高度吻合,因此NVIDIA将其GPU称为“ AI” PU出售,反之亦然。 同时,这就是为什么要将HBM内存添加到CPU以便将它们转换为AI和CPU都加倍的单元的原因。

之前发生的演变

在1990年代,DSP单元被用来加速新兴的多媒体应用。 这些单位现在在哪里? 一旦在CPU中实现SIMD单元,它们便消失了,不再需要为加速多媒体算法而实现DSP单元。

在AI的情况下,概念是相同的,在服务器的CPU中实现张量单元的想法是希望能够省去用于这些任务的GPU。 因此,从英特尔和AMD的业务角度来看,该信息可以概括为“不要购买 GPU 如果您已经可以在CPU上使用AI,则可以使用它。”

NVIDIA GPU的强大功能归功于着色器单元或SM,例如GA102的配置为82 SM,远远超过台式机CPU的内核数量。 在服务器CPU中,我们谈到了几十个内核,例如AMD EPYC最多可以达到64个内核,并将在下一代产品中不断发展。 由此,我们可以更好地了解在服务器CPU中采用HBM内存的方式,尤其是面对以AI为中心的应用程序越来越多的市场。