หน่วยความจำ HBM เป็นที่ทราบกันดีว่าใช้เป็นหน่วยความจำ VRAM ในการ์ดกราฟิกบางรุ่น แต่จุดหนึ่งที่เราจะเริ่มดูคือหน่วยความจำ HBM ในซีพียูเซิร์ฟเวอร์ เหตุผล? วัตถุประสงค์คือไม่ติดตั้งหน่วยความจำ HBM เป็นไฟล์ แรม หน่วยความจำ แต่เป็น LLC หรือแคชระดับสุดท้ายเพื่อเร่งงานบางอย่าง

หน่วยความจำ HBM ที่จนถึงตอนนี้เกี่ยวข้องกับ GPU สำหรับตลาด HPC จะเริ่มนำมาใช้โดยซีพียู มันนำอะไรมาบ้างและทำไมหน่วยความจำ HBM จึงใช้กับซีพียูและอะไรคือ อินเทล และ เอเอ็มดีเหตุผลในการใช้งาน?

การทบทวนหน่วยความจำ HBM

หน่วยความจำ HBM เป็นหน่วยความจำประเภทหนึ่งที่ประกอบด้วยชิปหน่วยความจำซ้อนกันหลายตัวซึ่งสื่อสารกับคอนโทรลเลอร์ของคุณในแนวตั้งโดยใช้เส้นทางผ่านซิลิกอน วงจรรวมสามมิติดังกล่าวถูกรวมเข้าด้วยกันและขายเป็นชิป HBM

ในการสื่อสารกับโปรเซสเซอร์ชิป HBM ไม่ได้ใช้อินเทอร์เฟซแบบอนุกรม แต่จะสื่อสารกับวัสดุพิมพ์หรือตัวประสานด้านล่างเพื่อส่งข้อมูล สิ่งนี้ช่วยให้คุณสามารถสื่อสารกับโปรเซสเซอร์โดยใช้พินจำนวนมากขึ้นและลดความเร็วสัญญาณนาฬิกาสำหรับแต่ละพิน ผลลัพธ์? หน่วยความจำ RAM ที่เทียบกับประเภทอื่นจะใช้เวลาน้อยกว่ามากเมื่อส่งข้อมูล

ไม่ได้ใช้หน่วยความจำ HBM ในตลาดในประเทศเนื่องจากมีราคาแพงส่วนประกอบของชิปหน่วยความจำหลายตัวทำให้ยากต่อการผลิตสำหรับผลิตภัณฑ์ขนาดใหญ่ แต่เหมาะสำหรับผลิตภัณฑ์ขนาดเล็ก ไม่ว่าจะเป็น GPU สำหรับการประมวลผลประสิทธิภาพสูงและแม้แต่ซีพียูสำหรับเซิร์ฟเวอร์ที่ HBM กำลังจะปรากฏตัว

ช่องหน่วยความจำเป็นส่วนสำคัญ

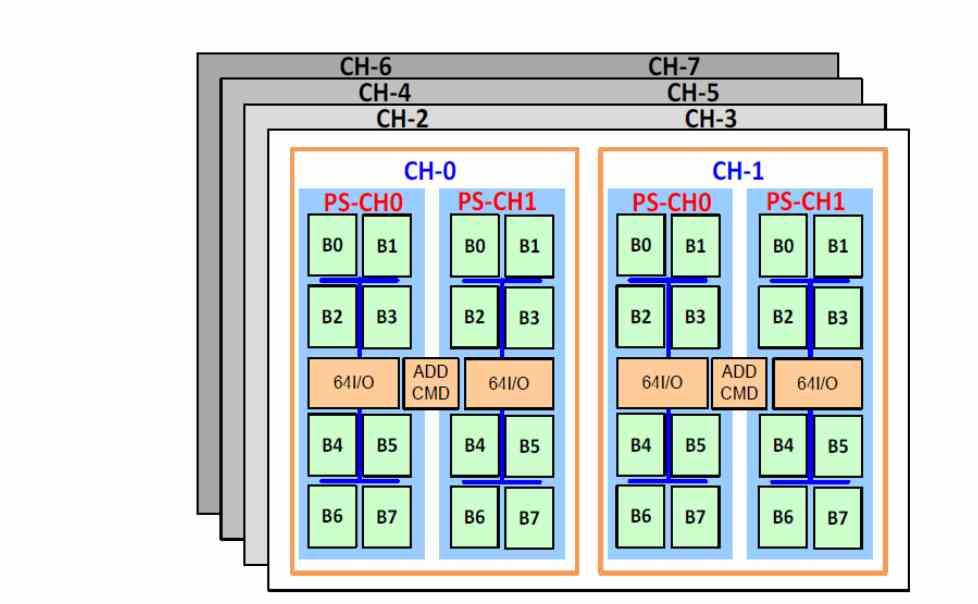

ความแตกต่างอย่างหนึ่งของหน่วยความจำ HBM เมื่อเทียบกับหน่วยความจำประเภทอื่นคือการรองรับช่องหน่วยความจำสูงสุด 8 ช่องซึ่งเป็นการกำหนดค่าที่มักใช้ในเซิร์ฟเวอร์ ดังนั้นหน่วยความจำ DDR8 4 แชนเนลจึงถูกแทนที่ด้วยหน่วยความจำ HBM 8 แชนเนลซึ่งมีแบนด์วิดท์สูงกว่ามากและมีเวลาแฝงที่ต่ำกว่า

เวลาแฝงต่ำกว่า? ใช่แล้วและทั้งหมดเกิดจากการอยู่บนวัสดุพิมพ์เดียวกันนั่นหมายความว่าการเข้าถึงหน่วยความจำในระหว่างการดำเนินการตามคำสั่งนั้นใช้เวลาน้อยลงและทำให้มีเวลาแฝงน้อยลง แต้มต่อ? หน่วยความจำ HBM2 มีความจุในการจัดเก็บน้อยกว่ามากดังนั้นจึงจำเป็นต้องเพิ่มหน่วยความจำไปยังระดับที่ต่ำกว่าของลำดับชั้น

เนื่องจากมีเวลาแฝงต่ำกว่า DDR4 จึงสามารถวาง HBM เป็นหน่วยความจำสำหรับ ซีพียู เหนือหน่วยความจำ DDR4 ในลำดับชั้นของหน่วยความจำและข้อมูลจะถูกถ่ายโอนจาก DDR4 ไปยังหน่วยความจำ HBM ตามที่จำเป็นและแม้แต่ใช้ NVMe SSD หน่วยความจำที่อยู่ภายใต้อินเทอร์เฟซ PCI Express ที่เร็วเพียงพอ แน่นอนว่าด้วยการใช้ระบบบีบอัดข้อมูลและคลายการบีบอัดข้อมูลแบบเรียลไทม์จาก SSD ไปยังแรม

เซิร์ฟเวอร์ CPU ต้องการหน่วยความจำ HBM เพื่ออะไร?

หน่วยความจำ HBM โดดเด่นโดยเฉพาะอย่างยิ่งสำหรับแบนด์วิดท์ขนาดใหญ่ซึ่งดูเหมือนว่าจะเกินจริงสำหรับ CPU แต่ต้องคำนึงถึงจุดหนึ่งที่ NVIDIA มีสถานะที่ยอดเยี่ยมในตลาดเซิร์ฟเวอร์อยู่ในปัญญาประดิษฐ์ด้วยการเพิ่มหน่วยเทนเซอร์ใน GPU นับตั้งแต่เปิดตัว Volta ดังนั้นระบบส่วนใหญ่ที่ใช้สำหรับการฝึกอบรมและการอนุมานสำหรับปัญญาประดิษฐ์จึงรวมถึงหน่วยดังกล่าว

สถานการณ์ของ Intel และ AMD เป็นอย่างไร? คำตอบคือการเพิ่มหน่วยประเภทนี้ในเซิร์ฟเวอร์ของพวกเขาในกรณีของ Intel พวกเขาคือหน่วย AMX และใน AMD ในขณะนี้ยังไม่ทราบว่าหน่วยที่พวกเขากำลังจะนำไปใช้คือหน่วยใด แต่ประเด็นของการเพิ่มไดรฟ์เหล่านี้คือการลดฮาร์ดแวร์ NVIDIA สำหรับเซิร์ฟเวอร์ ด้วยเหตุนี้เราต้องจำไว้ว่า AMD มีแผนกกราฟิกที่แข่งขันกับ NVIDIA แต่เราไม่สามารถลืม Intel Xe HPC และ Intel Xe HP โดย Intel ได้เช่นกัน

หน่วยสำหรับ AI ต้องการแบนด์วิดท์จำนวนมากในการทำงานซึ่งตรงกับ GPU อย่างมากดังนั้น NVIDIA จึงขาย GPU เป็น“ AI” PU หรือในทางกลับกัน ในขณะเดียวกันนี่คือเหตุผลว่าทำไมจึงต้องเพิ่มการใช้หน่วยความจำ HBM ให้กับซีพียูเพื่อแปลงหน่วยเป็นหน่วยที่เพิ่มขึ้นเป็นสองเท่าสำหรับทั้ง AI และ CPU

วิวัฒนาการที่เกิดขึ้นมาก่อน

ในช่วงทศวรรษที่ 1990 หน่วย DSP ถูกนำมาใช้เพื่อเร่งความเร็วแอปพลิเคชันมัลติมีเดียที่เกิดขึ้นใหม่ ตอนนี้หน่วยงานเหล่านี้อยู่ที่ไหน พวกเขาหายไปทันทีที่มีการนำหน่วย SIMD มาใช้ในซีพียูและการใช้หน่วย DSP เพื่อเร่งอัลกอริทึมมัลติมีเดียก็ไม่จำเป็นอีกต่อไป

ในกรณีของ AI แนวคิดก็เหมือนกันแนวคิดในการใช้หน่วยเทนเซอร์ในซีพียูสำหรับเซิร์ฟเวอร์ต้องการให้สามารถจ่าย GPU สำหรับงานเหล่านี้ได้ ดังนั้นจากมุมมองทางธุรกิจสำหรับ Intel และ AMD ข้อความสามารถสรุปได้ว่า“ อย่าซื้อ GPU ด้วยหน่วยสำหรับ AI เมื่อคุณสามารถทำได้บน CPU แล้ว”

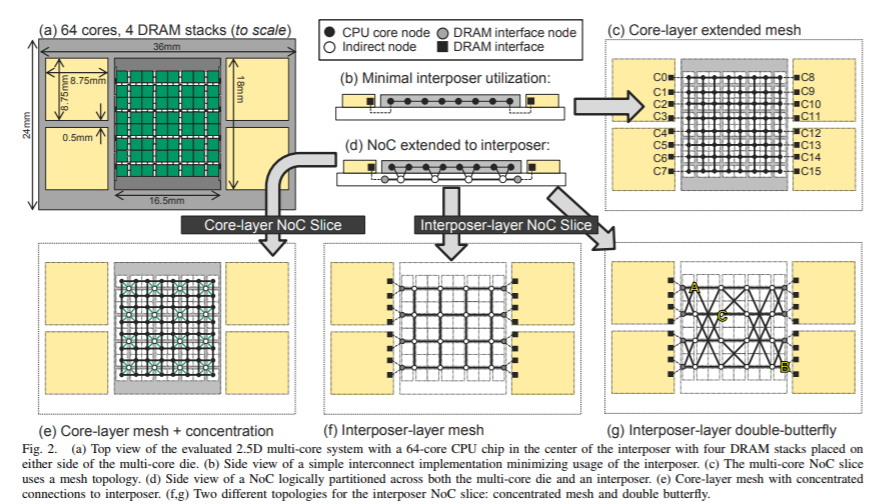

NVIDIA GPU นั้นมีพลังของ AI เนื่องจากมีหน่วย shader หรือ SM จำนวนมากเช่น GA102 มี 82 SM ในการกำหนดค่าซึ่งมากกว่าจำนวนคอร์ใน CPU เดสก์ท็อปมาก ในซีพียูเซิร์ฟเวอร์เราพูดถึงคอร์หลายสิบคอร์ตัวอย่างเช่น AMD EPYC สามารถเข้าถึงได้ถึง 64 คอร์และจะเติบโตในรุ่นต่อไป ด้วยเหตุนี้เราจึงเข้าใจได้ดีขึ้นว่าการนำหน่วยความจำ HBM มาใช้ในซีพียูเซิร์ฟเวอร์จะเป็นอย่างไรโดยเฉพาะอย่างยิ่งในตลาดที่มีแอปพลิเคชันที่เน้น AI