NVIDIA's G-SYNC-technologie was een revolutie in het introduceren van het concept van variabele verversingsfrequentie naar de pc om bepaalde beeldartefacten en fouten te elimineren. Tegenwoordig is deze technologie echter steeds minder op monitoren te zien en alles wijst erop dat deze na verloop van tijd stilletjes van de markt zou kunnen verdwijnen. Waarom zullen we na verloop van tijd geen monitoren met dergelijke technologie meer zien?

Toen G-SYNC-technologie op de markt kwam, ontbrak het bij de overgrote meerderheid van de monitoren aan technologieën voor variabele verversingsfrequenties, wat een understatement is om te zeggen dat de grafische kaart met de monitor communiceert om de verticale synchronisatie van de monitor te regelen. Een dergelijke mogelijkheid werd tot dan toe in geen enkele videostandaard overwogen, maar het was een goede klap voor de industrie. De eerste die er nota van nam, was uiteraard VESA, die de Adaptive Sync-standaard creëerde, waardoor NVIDIA gedwongen werd zijn eigen en AMD om het te gebruiken onder een nieuwe naam, FreeSync.

Dit is hoe NVIDIA's G-SYNC sterft

Een van de belangrijkste punten van NVIDIA met G-SYNC is dat het extra hardware nodig heeft om te werken, die in de monitor moet worden ingebouwd en niet bepaald goedkoop is. Hoewel het betere functies biedt dan Adaptive Sync en zijn afgeleiden, is dit waar het zogenaamde goed genoeg het uiteindelijk overneemt en ervoor zorgt dat de meeste gebruikers geen aanzienlijk meer willen betalen voor de oplossing van het merk Jen Hsen Huang.

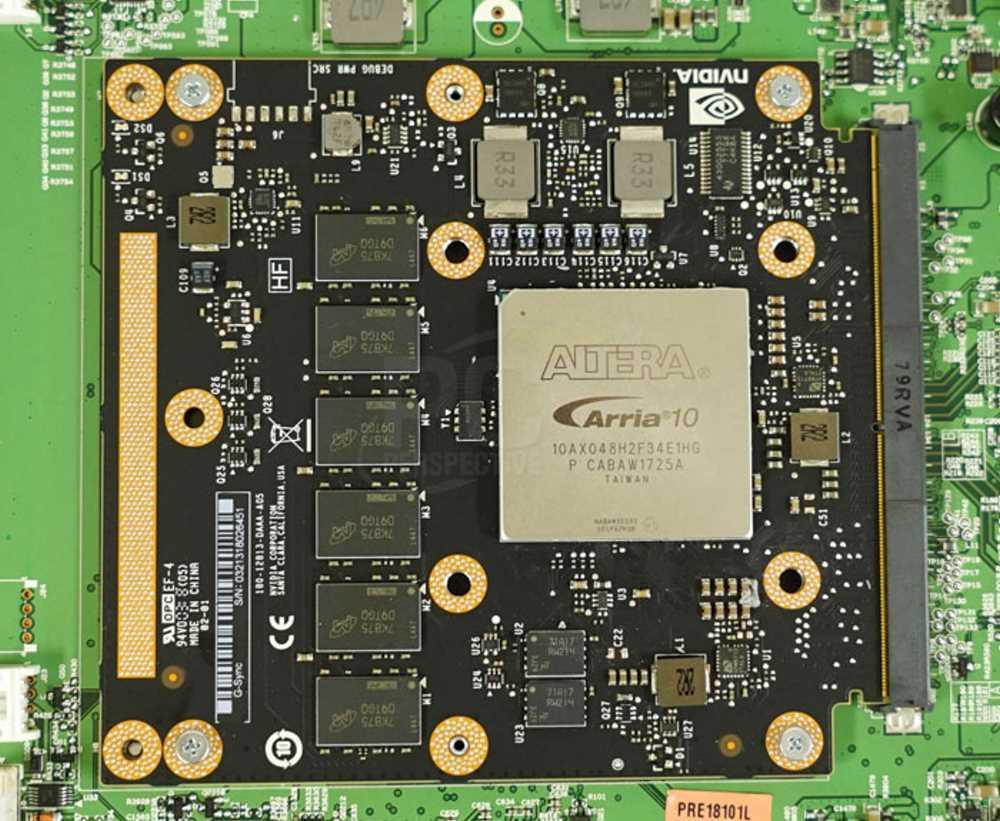

Dit bord dat je op de afbeelding hierboven ziet, bestaat uit een Intel FPGA en een reeks DDR-geheugenondersteuning. Er is geen G-SYNC-chip voor omdat het volume zo laag is dat je geen veel goedkopere ASIC kunt hebben om de klus te klaren. Dat wil zeggen, het aantal gebruikers dat een monitor koopt met ondersteuning voor genoemde technologie is niet voldoende om een processor voor genoemde monitoren te rechtvaardigen.

En hoeveel mag het kosten? Nou ja, ze worden niet direct verkocht, maar vanaf 500 euro in grote volumes gaan ze niet naar beneden. Het grappige is dat een ASIC 10 keer minder zou kosten dan de hele set. Zo niet, dan is de functionaliteit al jaren in DisplayPort-poorten geïntegreerd en kan elke grafische display-controller die dit ondersteunt Adaptive Sync al zonder extra kosten ondersteunen, aangezien het proces is geïntegreerd in de zender zelf en de video-ontvanger. Voeg daar nog het bestaan van VRR-ondersteuning in HDMI 2.1 aan toe en je hebt al de laatste nagel aan de doodskist.

Maak je over mij geen zorgen, ik ben al dood

Een van de commerciële valstrikken van NVIDIA is G-SYNC-compatibel, wat verwijst naar grafische kaarten die bedoeld zijn voor gebruik met monitoren met Adaptive Sync. Uiteindelijk proberen ze hetzelfde probleem op te lossen en het is de enige manier waarop ze hun merk kunnen bestendigen, in ieder geval totdat de interesse van mensen volledig verdwijnt of laag genoeg is.

Dat wil zeggen dat de overgrote meerderheid van de schermen die we in winkels zien, ondanks de initialen op de doos of op de behuizing, geen speciale circuits gebruiken en eenvoudige monitoren zijn met DisplayPort-aansluitingen. Dit betekent geld besparen voor fabrikanten en geen monitor buiten de marktprijs hoeven te ondersteunen, alleen maar omdat deze de beroemde groene oogmarkering heeft.