Una delle tecnologie che vediamo più ripetute guardando le specifiche di un monitor è l'HDR, ma da tempo non vediamo il passaggio da quello che chiamiamo SDR all'HDR in media come i videogiochi, per non parlare di Non abbiamo ne ho visto uno GPU progettato per HDR.

Se vi siete mai chiesti come sia possibile che non abbiamo assistito al salto definitivo verso gli schermi HDR tralasciando gli SDR, continuate a leggere che scoprirete il motivo.

Cos'è l'HDR e cosa lo differenzia dall'SDR?

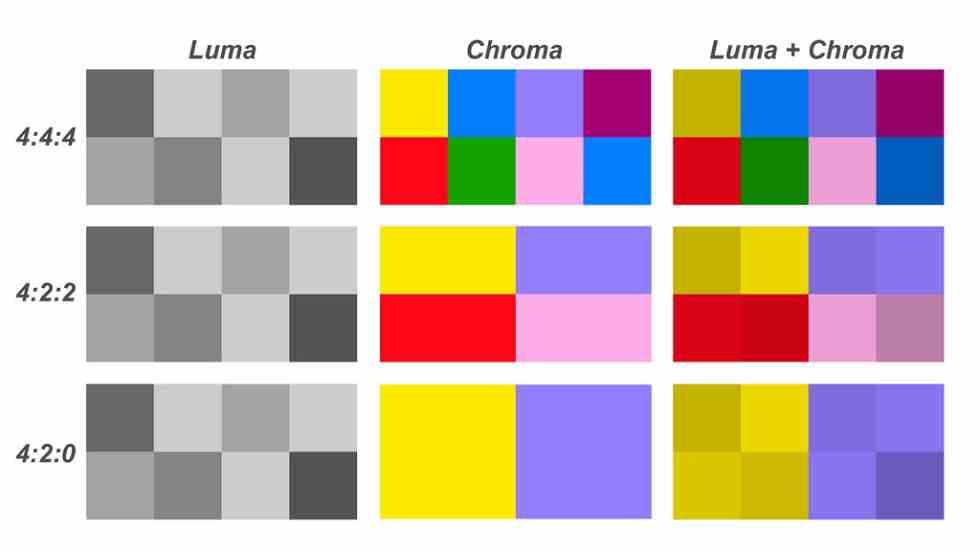

HDR è l'acronimo di high dynamic range, si basa sull'aumento della quantità di bit per componente RGB da 8 bit a 10 bit o anche 12 bit, ma HDR non si basa sull'aumento della crominanza e quindi della quantità di colori, ma piuttosto la loro luminanza, consentendo una maggiore luminosità e gamma di contrasto per ogni colore e una migliore rappresentazione di questi.

Tuttavia, mentre i monitor a colori a 24 bit hanno rapidamente sostituito quelli con una definizione del colore inferiore, lo stesso non è il caso dei monitor basati su HDR dove possiamo ancora trovarne un gran numero che non li supportano. Quindi la transizione non è mai stata completamente realizzata.

Uno dei motivi è che l'HDR è difficile da promuovere su uno schermo che non supporta quella gamma di colori, quindi nell'era dell'internet marketing è difficile mostrare qualcosa che si basa sulla percezione visiva delle persone e che non possono vedere .

Crominanza e luminanza

Ogni pixel rappresentato sullo schermo viene precedentemente memorizzato in un buffer di immagine che memorizza i valori dei tre componenti RGB: rosso, verde e blu. Ma la particolarità di questo modo di memorizzare le informazioni è che non viene memorizzata solo la crominanza, ma anche il livello di luminanza, che è il livello di colore o luminosità di quel colore.

Nei vecchi televisori in cui non c'era il colore, le immagini erano rappresentate da valori di luminanza e quando arrivava il colore entrambi i valori erano separati. Ma nel caso dell'informatica, sebbene gli schermi a tubi catodici siano stati utilizzati per quasi tre decenni, in realtà a livello di rappresentazione interna nel buffer dell'immagine, entrambi erano rappresentati allo stesso modo.

Per molto tempo, la massima rappresentazione a colori è stata di 24 bit di colore, che dà 16.7 milioni di combinazioni diverse, questo tipo di schermo è chiamato schermi SDR, per differenziarli dagli schermi HDR, che supportano una maggiore quantità di informazioni per pixel, con 10 e anche fino a 12 bit per componente.

Rendering grafico HDR e in tempo reale

L'HDR può essere rappresentato in due modi diversi:

- Il primo consiste nell'aggiungere più bit per componente a tutti i pixel nel buffer dell'immagine.

- Il secondo è aggiungere un nuovo componente.

Entrambe le soluzioni hanno senso quando si tratta di riprodurre immagini fisse e file video, ma nel caso di GPU utilizzate per rendere scene 3D in tempo reale la cosa si complica, in quanto ciò significa che tutte le unità GPU che manipolano i dati del pixel da una parte e dall'altra chi trasmette quegli stessi dati deve aumentare la loro precisione.

Questo di conseguenza ha la necessità di GPU con un numero maggiore di transistor e quindi questo significa GPU di dimensioni maggiori a parità di potenza o meno potenti se le dimensioni vengono mantenute. La soluzione adottata dai produttori? Il secondo, questo ha come conseguenza che le prestazioni dei giochi in modalità HDR sono inferiori rispetto a quando vengono renderizzati in SDR.

Le GPU non sono mai state progettate per HDR ma per SDR

Se aumentiamo la quantità di bit di informazione per pixel, logicamente spostando i dati durante il rendering scopriremo che la larghezza di banda necessaria sarà molto più alta, il che può tradursi in un calo delle prestazioni se tra la memoria che memorizza i dati e l'unità che li elabora, non si muovono abbastanza velocemente.

Ma. il movimento delle informazioni all'interno di un processore è costoso, soprattutto se parliamo di consumo energetico, essendo questo uno dei motivi per cui nessuna delle GPU negli ultimi anni è stata predisposta a funzionare in modo nativo con valori per pixel oltre gli 8 bit per componente. A causa del fatto che il valore più grande per la progettazione di nuovi processori, la più grande premessa in termini di prestazioni per lungo tempo è la potenza per watt.

Se, come altre tecnologie, le GPU fossero state progettate per l'HDR, allora la tecnologia sarebbe stata completamente standardizzata e ora tutto l'hardware e il software del PC sarebbe stato progettato per l'HDR, inoltre, sarebbe stato utilizzato da tutti.