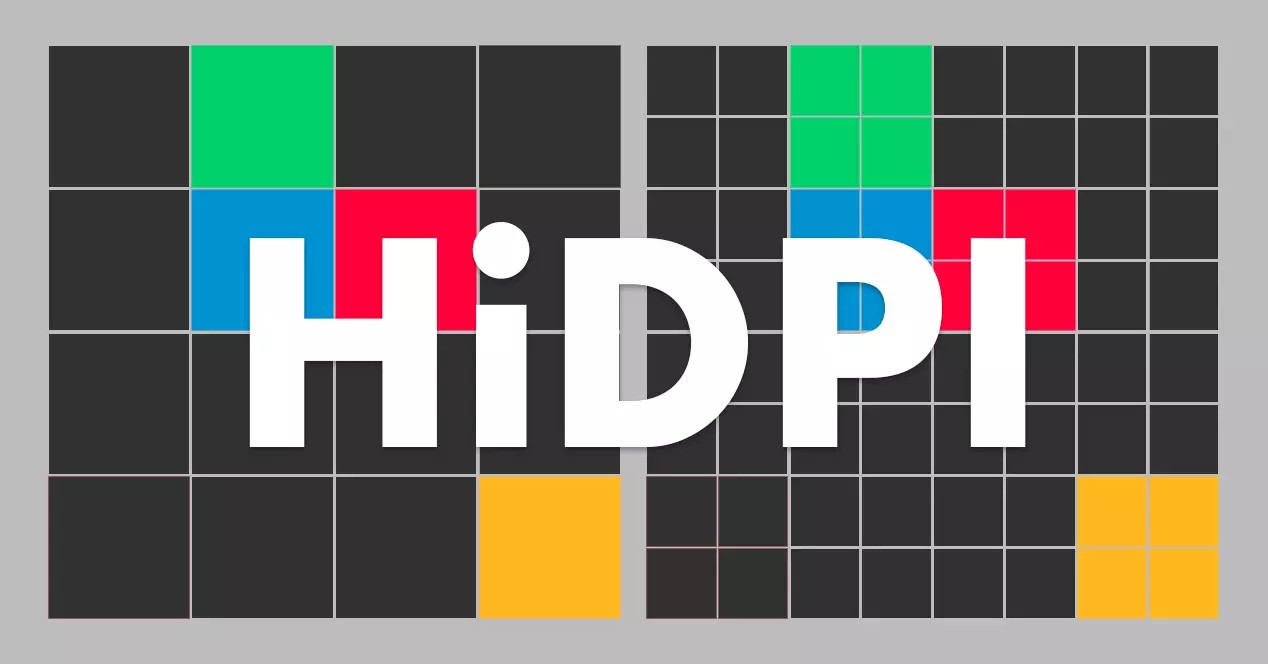

Om vi pratar om Semyazza. , du vet förmodligen inte vad vi pratar om, men om vi nämner 'Retina-skärm' , du kanske redan vet var skotten tar vägen. Medan alla vet om Apples högdensitetsskärmsteknik, HiDPI är ett ämne som inte många förstår eftersom informationen vi hittar på Internet är ganska förvirrande. I det här inlägget ska vi lösa de tvivel som finns runt denna nomenklatur som kämpar för att bli en ny standard.

Vad betyder HiDPI?

HiDPI betyder "Höga punkter per tum", vilket på spanska skulle översättas som "hög täthet av pixlar per tum" . Namnet som denna teknik marknadsförs under varierar beroende på tillverkare, där 'Retina' är den version som har fått mest hype tack vare att ha ett företag som Apple bakom sig.

Kortfattat specificerar HiDPI att det finns en perfekt korrelation mellan den fysiska pixeln på en skärm och en virtuell pixel. Oroa dig inte om allt detta låter som kinesiskt för dig eftersom många bildskärms- och datortillverkare fortfarande inte förstår detta koncept. Lite senare kommer vi att förklara vad HiDPI består av med flera exempel med vilka du kan förstå detta koncept med stor tydlighet.

HiDPI är viktigare än 4K

Marknaden är full av produkter som säljs i 4K-upplösning. Branschen har dock aldrig gjort sin hemläxa på detta område. 4K är ingen standard , även om vi tror det, och det tilldelas inte ett riktigt antal pixlar i längd eller bredd, vilket var fallet i tidigare standarder (480p, 720p och 1080p).

Så... vad är 4K? Dess definition hänvisar inte till en skärmstorlek eller upplösning, utan till en bildformat det är ungefär 4,000 XNUMX pixlar horisontellt. Uppenbarligen skapar denna definition en hel del förvirring . Till exempel är en 4K-tv en som har en matris på 3,840 2,160 x 16 9 pixlar med ett bildförhållande på 4:4,096. Och en 2,160K digital bioduk är 17 9 gånger XNUMX XNUMX pixlar, med ett bildförhållande på XNUMX:XNUMX.

Densitet är frågan

Nu förstår vi att definitionen av 4K i sig inkluderar en rad olika upplösningar runt 4 miljoner pixlar totalt. Låt oss säga att du går till din betrodda butik och köper en panel med 3840 x 2160 pixlar. Är det 4K? Ja. Är det en HiDPI-skärm? Det beror på panelens storlek. Låt oss gå med några exempel för att se det tydligare:

- Om du pratar om en datorskärm och det handlar om 32 inches , är den troligen utformad för att ses på ungefär en meters avstånd. Varje fysisk pixel på skärmen kommer att motsvara en virtuell pixel i operativsystemet. Storleken på skärmen gör att du kan ha hundratals ikoner på skrivbordet. Du kan ha många applikationer öppna parallellt och du kommer inte ha problem med att läsa text i något av dessa fönster eftersom typsnittet blir fullt läsbart. Och nej, vi skulle inte prata om en HiDPI-skärm , men en LoDPI, eftersom dess skala är 1x.

- Om den upplösningen är på en 15-tums bärbar dator , skulle vi ha ett verkligt problem om skalan var inställd på 1x. Du kunde inte läsa absolut någonting eftersom det inte finns någon koordination mellan skärmens densitet och systemets gränssnitt . Det blir då när vi måste aktivera duplicering av pixlar , det vill säga HiDPI. Detta kommer att göra att varje pixel på vår skärm blir fyra (en dubblering på skärmens X-axel och en annan dubblering på Y-axeln). Nu kommer varje kvadrat med fyra fysiska pixlar på vår skärm att motsvara en virtuell pixel på 1920 gånger 1080 upplösning, vilket är en upplösning som vi känner mycket väl till. Genom att göra denna process, det blir inga problem med skärpan . Skalan måste justeras till perfektion, texten ska synas tydligt och det får inte finnas någon typ av ikon eller suddig meny på vår skärm.

- Tänk om vi pratar om en 13-tums laptopskärm ? Vid 1x kommer vi att ha ett ännu större problem än med den 15-tums bärbara datorn. Och om vi dubblar pixlarna (det vill säga om vi får 4 pixlar för varje virtuell pixel) allt kommer fortfarande se liten ut . Så vad händer om vi tar en 3 x 3 pixel matris? Vi kommer inte att lösa problemet heller, eftersom om vi konverterar varje pixel till nio har vi överbromsat. I dessa fall måste vi välja en annan fysisk lösning. För en 13-tums skärm , Full HD-upplösningen är inte idealisk. Tillverkare som menar allvar med sina produkter har historiskt använt den 1,600 med 900 pixel matris. Så för att skala rätt, en 13-tums bärbar dator som vill ha en upplösning nära 4K måste ha en panel på 3,200 1,800 x XNUMX XNUMX pixlar . Det kan låta dumt (det är bara några hundra pixlar från varandra på varje axel), men dess användbarhet kommer att vara väldigt olika. Objekt på skärmen kommer att ha rätt bildförhållande, till skillnad från matrisen på 3840 x 2160 pixlar, som inte alls kommer att se bra ut. Åh, och om du undrade, en 13-tums skärm med en 3,200 1,800 x 4 XNUMX pixlar panel kan inte betraktas som XNUMXK. Men det är HiDPI . Nyfiken, eller hur?

Vad händer när en skärm eller ett system inte stöder HiDPI?

Utöver vad vi just har förklarat i föregående stycke, finns det ett extra problem när vi pratar om skärmar som inte stöder HiDPI , som för övrigt är de allra flesta skärmar som vi hittar på marknaden. För att förenkla exemplet, föreställ dig att vi har en 15-tums bärbar dator framför oss. Vi vet att 1920 gånger 108o är en korrekt upplösning för en skärm av denna storlek. Tänk om vi istället för att använda en HiDPI-skärm (dvs. 3840 x 2160 pixlar i exemplet ovan) använder en skärm med en skala på 1.5x istället för 2x ? Jo, för att hela gränssnittet ska uppta samma utrymme som i en Full HD, måste systemet skalas 1.5 gånger.

Men här är något som inte stämmer. Har du redan märkt det? Det är omöjligt att få det rätt. Vi kommer att zooma in på skärmen och vi kommer att visa pixlarna separat. Eftersom det inte finns någon 4:1, 9:1 eller 16:1 korrelation måste varje pixel nu fysiskt upptar en och en halv pixel. Och halvpixlarna existerar inte .

![]()

Vad gör systemet då? Kompensera med den berömda aliasing , som fortfarande är en oskärpa filter som gör pixeln suddig för att simulera den saknade halvpunkten. Resultatet är en total katastrof och när det ges i text bevisar det att en tätare skärm inte nödvändigtvis är bättre. Pirelli sa att "Ström utan kontroll är värdelös", och detta är det tydliga exemplet på att tillverkare borde börja sätta i batterierna och börja dosera den kraften. HiDPI är inte marknadsföring , men ett sigill som garanterar att upplösningen för en bildskärm inte har valts godtyckligt.

Vad är skillnaden mellan HiDPI och Retina Display?

Objektivt sett ingen. 'Retina Display' är inget annat än en handelsnomenklatur registrerad av Apple för att hänvisa till dess HiDPI-kompatibla skärmar. När Apple säljer oss en produkt med 'Retina Display', hänvisar äppelmärket till att upplösningen på dess produkter är utformad så att det finns inga skalproblem eller suddiga gränssnitt. De använder samma "Retina" varumärke för en 27-tums 5120 x 2880 pixlar iMac som med den berömda iPhone 4, som hade en 3.5-tums skärm och en panel på 960 x 480 pixlar. I båda fallen har de två produkterna en skärm fyra gånger så tät som sina föregångare.

Varför får 4K så mycket hype och inte HiDPI?

Tyvärr, för marknadsföring skäl. Det sägs mycket på Internet att Apple ständigt försöker sälja oss motorcykeln med sin teknik, men sanningen är att de går före när de säljer oss Retina Display. Med det tidigare fallet med den 13-tums bärbara datorn som ett exempel, föredrar mer än en tillverkare att sälja en skärm med fel upplösning (det vill säga den överensstämmer inte med HiDPI) så länge det står att det är det 4K på etiketten. Det är därför vi sa i början att HiDPI är viktigare än 4K, eftersom det inte är någon nytta att ha en tätare skärm om du ska ha en felaktig skala eller så kommer du att behöva kisa för att se filerna på skrivbordet ordentligt.