NVIDIAs G-SYNC-teknik var en revolution i att föra konceptet med variabel uppdateringsfrekvens till datorn för att eliminera vissa bildartefakter och fel. Men idag ses denna teknik allt mindre på bildskärmar och allt tyder på att den med tiden tyst kan försvinna från marknaden. Varför kommer vi att sluta se bildskärmar med sådan teknik med tiden?

När G-SYNC-tekniken kom ut på marknaden saknade de allra flesta bildskärmar tekniker med variabel uppdateringsfrekvens, vilket är en underdrift för att säga att grafikkortet kommunicerar med bildskärmen för att styra bildskärmens vertikala synkronisering. En sådan kapacitet övervägdes inte i någon videostandard förrän då, men det var ett bra slag på handleden för branschen. Den första att notera var uppenbarligen VESA, som skapade Adaptive Sync-standarden, vilket tvingade NVIDIA att förbättra sin egen och AMD för att använda den under ett nytt namn, FreeSync.

Det är så här NVIDIAs G-SYNC håller på att dö

En av NVIDIAs nyckelpunkter med G-SYNC är att det kräver ytterligare hårdvara för att fungera, som måste byggas in i bildskärmen och som inte är direkt billig. Även om det ger bättre funktioner än Adaptive Sync och dess derivat, är det här som det så kallade good enough slutar med att ta över och gör att de flesta användare inte vill betala en ansenlig extra för lösningen från Jen Hsen Huangs varumärke.

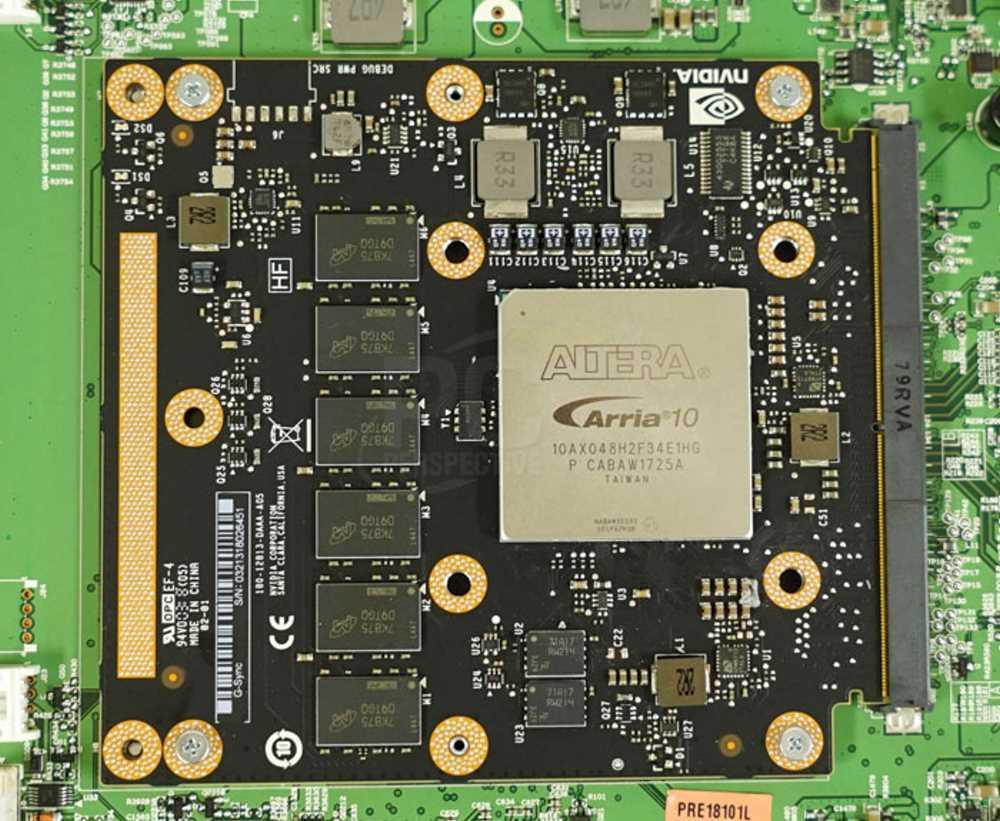

Denna tavla som du ser på bilden ovan består av en Intel FPGA och en rad DDR-minnesstöd. Det finns inget G-SYNC-chip för det eftersom volymen är tillräckligt låg för att du inte kan ha en mycket billigare ASIC för att göra jobbet. Det vill säga antalet användare som köper en bildskärm med stöd för nämnda teknik är inte tillräckligt för att motivera en processor för nämnda bildskärmar.

Och hur mycket kan det kosta? Jo, de säljs inte direkt, men från 500 euro i stora volymer går de inte ner. Det roliga är att en ASIC skulle kosta 10 gånger mindre än hela setet. Om inte, har funktionen redan integrerats i DisplayPort-portar i flera år och alla grafikskärmskontroller som stöder det kan redan stödja Adaptive Sync utan extra kostnad, eftersom processen är integrerad i själva sändaren och videomottagaren. Lägg därtill att det finns VRR-stöd i HDMI 2.1 så har du redan den sista spiken i kistan.

Oroa dig inte för mig, jag är redan död

En av NVIDIAs kommersiella fällor är G-SYNC-kompatibel, vilket hänvisar till grafikkort avsedda att användas med bildskärmar med Adaptive Sync. I slutändan letar de efter att lösa samma problem och det är det enda sättet de kan vidmakthålla sitt varumärke, åtminstone tills folks intresse försvinner helt eller är tillräckligt lågt.

Det vill säga, de allra flesta skärmar som vi ser i butik, trots att de har initialerna på kartongen eller på höljet, använder inte specialiserade kretsar och är enkla bildskärmar med DisplayPort-anslutningar. Vilket innebär att man sparar pengar för tillverkarna och inte behöver stödja en bildskärm utanför marknadspriset, bara för att den har det berömda gröna ögonmärket.