NVIDIA Ampere grafik kort var de första att införliva GDDR6X grafikminne, nästa steg när det gäller prestanda till GDDR6. Tack vare detta minne har de lyckats motsvara 21 Gbps bandbredd som vi hade vid den tiden, men de har uppnått det på ett innovativt sätt som ger flera fördelar ... och vissa nackdelar. Var förändringen värt det? Låt oss se det.

Som vi redan har nämnt, GDDR6X grafikminne is inte en JEDEC-standard , men är en design som i detta fall är exklusiv för Micron Technology, en ny minnesteknik som gör att du kan höja prestanda till nya höjder. Vi kommer inte att undersöka fördelarna och nackdelarna med att en tillverkare har exklusiva rättigheter till tekniken, men vi kommer att se om förändring med avseende på GDDR6 har varit värt det eller inte.

GDDR6X vs GDDR6, hur är de olika?

Vid det här laget kommer ingen att tvivla på att GDDR6X representerar ett språng i många avseenden över GDDR6-grafikminnet (som fortfarande är populärt i de flesta spel bärbara datorer under 1500), så om någon hade några tvivel kan de redan skingra dem: när det gäller prestanda är GDDR6X överlägsen, och detta är anledningen till varför som NVIDIA har riskerat att introducera grafikkort i sin Ampere-arkitektur, varken mer eller mindre.

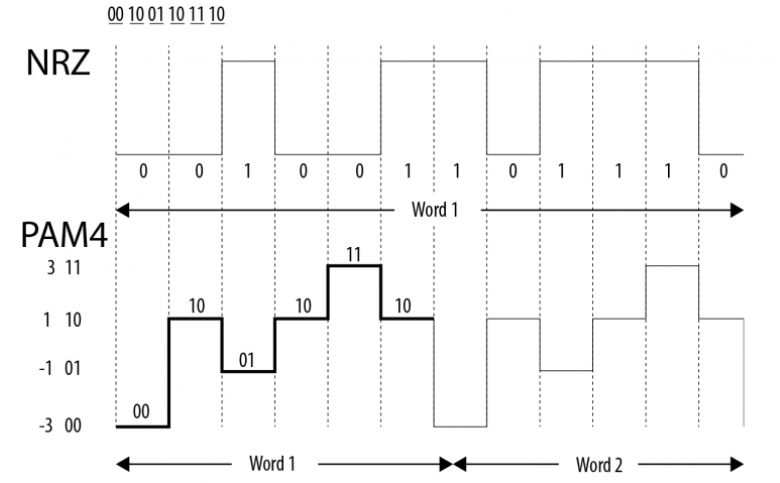

För att uppnå denna prestationsökning har Micron använt en teknik som redan använts i nätelektronik utan att gå längre, och det är att använda PAM4-kodningen i motsats till NRZ-kodning av GDDR6 . PAM står för Pulse Amplitude Modulation, och vad den gör är att den kan generera olika binära värden med hjälp av den elektriska signalens amplitud.

Medan NRZ-kodning endast kan generera sådana och nollor, sålunda PAM4 kan generera fyra binära värden per klockcykel, så den kan koda 2 bitar per cykel jämfört med endast 1 av NRZ, vilket fördubblar bredden.

Trots det faktum att med PAM4-kodning kan GDDR6X-minnet fördubbla bandbredden jämfört med GDDR6, för tillfället har de lämnat bandbredden med samma 21 Gbps som redan uppnåddes med en hög frekvens i GDDR6. Varför göra detta? Eftersom de får samma bandbredd med lägre hastighet, vilket innebär många fördelar:

- Mindre genererad värme.

- Mindre konsumtion.

- Mindre spänning.

- Större marginal för överklockning.

- De kan potentiellt fördubbla prestanda.

Micron kan skryta med att den har föreställt sig minnet med den här nya tekniken, och NVIDIA har satsat mycket hårt på det. Naturligtvis är potentialen enorm och du kan nå minnesnivåer som du aldrig sett tidigare.

Är det värt förändringen?

Att använda denna typ av grafikminne har nu också en rad tekniska nackdelar, förutom den som redan nämnts, vilket inte är något annat än det faktum att Micron tillverkar det exklusivt och reglerar dess pris och produktion (detta gör GDDR6X dyrare och knappt än GDDR6).

Genom att använda PAM4-kodningen har vi redan förklarat att fyra binära värden genereras per klockcykel, vilket möjliggör kodning av 4 bitar per cykel kontra 2 av NZR-kodningen. Detta gör spänningsregulatorn mycket viktigare, och ett fel i dess känslighet kan orsaka minnesfel och orsaka kl minst läs- / skrivfel i VRAM och leder till artefaktproblem, hängningar, blå skärmar etc.

Detta är inte att säga att GDDR6X kommer att ha minnesfel långt ifrån, men det kommer helt enkelt att vara mycket mer känsligt och benäget för dem och kommer att vara mycket mer beroende av styrenheten. Den goda delen är att eftersom den fungerar vid en lägre spänning och genererar mindre värme, kompenseras denna nackdel delvis.

Att svara på frågan om övergången till denna nya minneteknik har varit värt det, naturligtvis är svaret ja. Även om det för närvarande inte utnyttjar sin fulla potential när det gäller prestanda, finns det potential att fördubbla minnesbandbredden, och för närvarande har de redan lyckats för att avsevärt minska konsumtionen och den genererade värmen, som redan är förmåner som är väl värda det.

Nu återstår att se vad framtiden har på VRAM-arenan. NVIDIA har mycket potential att utnyttjas med denna typ av minne, men vi är fortfarande på bekostnad av "svaret" från AMD i detta avseende, eftersom de också har gett sina löften. Å andra sidan har NVIDIA varit en pionjär när det gäller att använda GDDR6X, men vi kan inte glömma att AMD var föregångarna till HBM-minne som senare visade sig vara ett ganska fiasko.