Fallet av Facebook över hela världen som inträffade på måndagen har varit ett före och efter i företaget, och det är att de var helt frånkopplade från Internet i mer än 5 timmar, något utan motstycke för ett av de största företagen i världen. Nu när Facebook -plattformen, WhatsApp och Instagram har återhämtat sig 100% från kraschen som inträffade i måndags, har Facebook -teamet publicerat detaljer om hur kraschen hände, varför den hände och även hur de lyckades åtgärda den. Vill du veta alla detaljer om den största kraschen i Facebook -historien hittills?

Hur fungerar Facebook och varför inträffade dess totala undergång?

Facebook har indikerat att det totala avbrottet i tjänsten över hela världen berodde på ett fel i systemet som hanterar kapaciteten i företagets ryggrad, denna ryggrad är "ryggraden" i Facebook -nätverket för att ansluta alla datacenter som Facebook har spridit alla över hela världen, som består av tusentals servrar och hundratals kilometer fiberoptik, eftersom de också ansluter dess datacenter med sjökablar. Vissa Facebook -datacenter har miljontals servrar som lagrar data och har en hög beräkningsbelastning, men i andra fall är anläggningarna mindre och ansvarar för att ansluta ryggraden till Internet i allmänhet för att människor ska kunna använda sina plattformar.

När någon användare som vi ansluter till Facebook eller Instagram, begäran om data går från vår enhet till närmaste anläggning geografiskt, för att senare kommunicera direkt med ryggraden för att komma åt de största datacenterna, det är här den hämtar den begärda informationen och är bearbetat, så att vi kan se det på smarttelefonen.

All datatrafik mellan de olika datacentren hanteras av routrar, som bestämmer vart inkommande och utgående data ska skickas. Som en del av sitt dagliga arbete behöver Facebooks teknikteam underhålla denna infrastruktur och utföra uppgifter som att uppgradera routrar, reparera fiberlinjer eller lägga till mer kapacitet på vissa nätverk. Detta var problemet med den globala Facebook -kraschen i måndags.

Under underhållsarbetet skickades ett kommando i avsikt att utvärdera tillgängligheten för den globala ryggradskapaciteten, men det av misstag avbröt alla ryggradskopplingar och kopplade bort alla Facebook -datacenter globalt. I allmänhet använder Facebook system för att granska den här typen av kommandon och mildra eller undvika sådana här fel, men ett fel (fel) i detta verktyg för kontroll och ändring av kontroller förhindrade att orderns utförande stoppades och sedan föll allt sönder.

Vad hände på Facebook när jag körde kommandot?

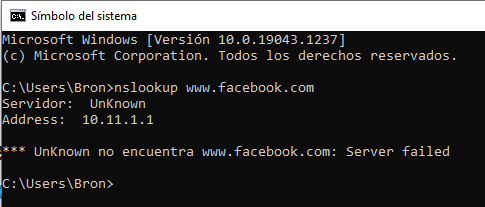

Så snart kommandot utfördes orsakade det en total frånkoppling av Internet- och datacenteranslutningarna, det vill säga att vi inte kunde komma åt någon av Facebook -tjänsterna eftersom de inte längre var synliga på Internet. Dessutom orsakade denna totala frånkoppling ett andra katastrofalt fel i systemet, närmare bestämt i DNS. En av de uppgifter som mindre datacenterinstallationer utför är att svara på DNS-frågor, dessa frågor besvaras av auktoritativa namnservrar som har välkända IP-adresser och som annonseras för resten av Internet med protokollet BGP.

För att säkerställa en mer tillförlitlig drift har Facebook DNS -servrarna att stänga av dessa BGP -annonser om de inte kan prata med Facebooks datacenter själva, eftersom detta indikerar att nätverksanslutningen inte fungerar korrekt. Med den totala störningen av ryggraden, vad dessa DNS -servrar gjorde var att ta bort BGP -annonserna. Resultatet av detta är att Facebooks DNS -servrar blev oåtkomliga trots att de fungerade perfekt, av den anledningen kunde resten av världen inte komma åt Facebook -tjänster.

Logiskt var hela processen på några sekunder, medan Facebook -ingenjörer försökte ta reda på vad som hände och varför de stod inför två kritiska problem:

- Det var inte möjligt att komma åt datacenterna normalt, eftersom nätverken var helt nere från det första problemet.

- Kraschen av DNS bröt många interna verktyg som vanligtvis används för att undersöka och lösa problem av denna typ.

Tillgången till huvudnätverket och out-of-band-nätverket var nere, ingenting fungerade, så de var tvungna att fysiskt skicka ett team av människor till datacenteret för att åtgärda problemet och starta om systemet. Detta tog lång tid eftersom den fysiska säkerheten i dessa centra är maximal, i själva verket, vilket bekräftas av Facebook, är det till och med svårt för dem att fysiskt komma åt dem för att göra ändringar för att undvika eller mildra eventuella fysiska attacker på deras nätverk. Detta tog lång tid tills de kunde autentisera sig till systemet och se vad som hände.

Kommer tillbaka till livet ... men så småningom för att inte kasta hela systemet

När ryggradens anslutning återställdes i de olika regionerna i Facebooks datacenter fungerade allt bra igen, men inte för användare. För att undvika en kollaps i deras system på grund av det stora antalet användare som ville komma in, var de tvungna att aktivera tjänsterna så småningom för att undvika att orsaka nya problem på grund av den exponentiella ökningen av trafiken.

Ett av problemen är att de enskilda datacenterna använde väldigt lite elektrisk ström, och plötsligt kunde vända all trafik göra att elnätet inte kunde absorbera så mycket extra ström och kan också riskera elektriska system. Jag cachelagrade dem. Facebook har utbildat sig för den här typen av händelser, så de visste mycket väl vad de skulle göra för att undvika fler problem vid en global krasch som den som har hänt. Även om Facebook hade simulerat många problem och kraschar på sina servrar och nätverk, hade de aldrig övervägt en total droppe av ryggraden, så de har redan sagt att de kommer att leta efter ett sätt att simulera detta inom en snar framtid för att förhindra att det kommer tillbaka. passera och det tar så lång tid att fixa.

Facebook har också indikerat att det var mycket intressant att se hur fysiska säkerhetsåtgärder för att förhindra obehörig åtkomst fick tillgång till servrar att sakta ner enormt när de försökte återhämta sig från detta misslyckande globalt. I vilket fall som helst är det bättre att dagligen skydda dig från dessa typer av problem och ha en något långsammare återhämtning än att slappna av datacentrernas säkerhetsåtgärder.