Încetul cu încetul, abandonarea discului este un fapt și folosirea unităților SSD crește din ce în ce mai mult. Cu toate acestea, această schimbare nu are loc doar în lumea computerelor de acasă, ci și în servere. Protocolul NVMe-oF are foarte mult de-a face cu toate acestea. Ce reprezintă aceste acronime și de ce pot modela viitorul stocării pe computer?

Tranziția progresivă către utilizarea SSD-urilor NVMe pentru stocare în toate sectoarele de calcul continuă în mod constant, determinist și fără frâne. Acestea includ sisteme de rețea, care astăzi intercomunica mai multe computere între ele, fie într-o rețea locală, fie într-un centru de date.

Majoritatea unităților de stocare sunt de tip DAS sau Direct Access Storage în care doar PC-ul care are instalată respectiva unitate poate accesa conținutul acestuia și, prin urmare, într-un mediu de rețea este necesar să se dezvolte protocoale care, de exemplu, într-un mediu de centru de date. sau un supercomputer format din zeci sau sute de unități permite accesul la întreaga infrastructură de stocare.

Cum este comunicarea într-un centru de date?

Înainte de a intra în modul în care funcționează NVMe-oF și în ce constă. Trebuie să ținem cont de faptul că tehnologiile utilizate într-un centru de date sau într-o rețea locală pentru a intercomunica stocarea internă a acestuia se numesc SAN, care înseamnă Zona de depozitare Reţea sau stocare în rețea locală. Pentru aceasta, astăzi sunt folosite trei tehnologii diferite, toate bazate pe veteranul SCSI.

- Protocolul Fibre Channel (FCP): It este un protocol care transportă Comenzi SCSI printr-o rețea de fibră optică , deși se poate face și pe linii de cupru. Vitezele lor pot varia de la 1 la 128 GB/s.

- iSCSI: Ce combină Protocol Internet TCP/IP și comenzi SCSI . Acesta se bazează pe plăci de rețea convenționale și este proiectat pentru rețele cu lățime de bandă foarte mică, deoarece este limitat la capacitățile lor Ethernet. Deci viteze de 1 GB / s sunt comune, deși 10 GB / s incep sa se vada in ultima vreme.

- SCSI atașat în serie: cea mai folosită dintre toate și bazată pe cabluri SAS care permit conectarea a până la 128 de unități de stocare prin adaptoare de magistrală gazdă sau HBA. Viteza acestora poate fi de 3 GB/s, 6 GB/s, 12 GB/s și chiar 22.5 GB/s.

Cu toate acestea, toate aceste tehnologii sunt destinate să comunice cu unitățile de disc convenționale. Și trebuie să presupunem că accesul la un hard disk este diferit de cel al unei unități bazate pe flash. Ceea ce face ca utilizarea acestor protocoale să nu fie cea mai potrivită.

Ce este NVMe-oF?

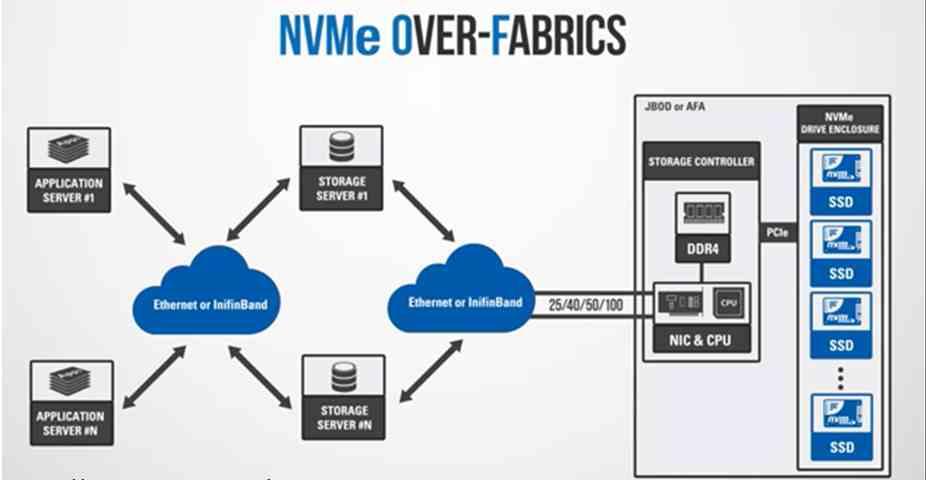

Ei bine, ele sunt acronimul pentru NVMe over Fabric și este că acest protocol nu a fost planificat doar pentru a comunica cu unități de memorie flash sau nevolatile, ci și pentru intercomunicarea diferitelor elemente dintr-un sistem prin infrastructuri de intercomunicație. Trebuie să înțelegem că ne referim la o structură de comunicare între două elemente. Care pot fi două procesoare, a RAM și un procesor, un accelerator și o memorie ROM și așa mai departe. Să nu uităm că topologiile folosite pentru acest caz folosesc aceleași structuri ca și în telecomunicații, dar la scară foarte mică.

Cu toate acestea, acesta va fi folosit pentru a comunica SSD-urile NVMe prin rețea. Fie pentru a comunica diferite elemente către Procesor în cadrul aceluiași PC sau, în caz contrar, printr-o placă de rețea. Deci vorbim de centre mari de date. Avantajul utilizării NVMe-oF? Ei bine, în comparație cu protocoalele SATA și SAS utilizate în hard disk, acestea sunt capabile să suporte o coadă de până la 65,000 de solicitări end-to-end și până la 65,000 de comenzi diferite per cerere , în comparație cu una singură de 1 singură cerere și mai puțin de 256 de comenzi. . Ceea ce este esențial în mediile cu tot mai multe nuclee care fac cereri de date către stocare care ar putea satura rețeaua.

Tipuri de NVMe-OF

În prezent există două variante, care sunt următoarele:

- NVMe-of cu canal de fibră optică: care a fost proiectat să se integreze în centrele de date și serverele existente prin sprijinirea protocoalelor vechi, cum ar fi SCSI. Acest lucru va ușura tranziția către utilizarea unităților flash în centrele de date și serverele existente.

- NVMe prin Ethernet: care este folosit pentru ca două computere să facă schimb de date prin intermediul acces direct la memorie la distanță (RDMA) și, prin urmare, se referă la faptul că două computere pot schimba conținutul memoriilor lor flash în SSD-uri NVMe fără ca CPU-ul oricărui sistem să intervină în proces. În acest caz, comunicarea nu folosește așa-numitele pachete SCSI.

Să nu uităm că memoriile NAND Flash sunt numite și RAM nevolatilă datorită faptului că natura lor la accesarea lor este aceeași cu cea a memoriei RAM, doar că nu pierd informații atunci când nu mai primesc o sarcină electrică. Acest lucru permite implementarea tehnologiilor utilizate pentru a intercomunica două memorii RAM separate pentru a face acest lucru cu diferitele memorii flash.

Despre ce viteze vorbim?

Să nu uităm că SSD-urile NVMe folosesc interfețe PCI Express, așa că versiunea bazată pe fibră optică a acesteia va fi unul dintre posibilii candidați pentru a conecta diferitele SSD-uri NVMe în infrastructura unui centru de date sau a unei rețele locale. Cu toate acestea, Ethernet va continua să domine ca protocol de comunicație standard pentru rețele pentru o lungă perioadă de timp. Nu există nicio îndoială că interfețele de rețea la viteze de 50, 100 și chiar 200 Gigabiți pe secundă au fost în dezvoltare și vor fi implementate în curând în centrele de date.

Viitorul NVMe-oF este și pe computer

RDMA-ul integrat în NVMe-oF nu este o tehnologie nouă, deoarece este implementat pe piețe de nișă de ani de zile, datorită faptului că controlerele de rețea integrate sau NIC-urile cu RDMA erau foarte scumpe și necesitau tehnicieni de înaltă specializare pentru întreținerea lor. implementarea lui a fost costisitoare. Cu toate acestea, va fi esențial în viitor chiar și pe computerele desktop. Motivul pentru aceasta este că infrastructurile interne ale procesoarelor evoluează spre ceea ce numim NoC. În ele, fiecare element al procesorului are o mică placă de rețea integrată și o adresă IP cu care să comunice cu restul elementelor prin ceea ce am putea numi un procesor de rețea integrat în procesor.

Nu este un secret pentru nimeni care cunoaște problema că, în același mod în care controlerele de rețea au fost văzute integrate în procesoare, următorul pas este să o faci cu controlerele flash găsite în SSD-urile NVMe. Mai mult, avantajul implementării NVMe-oF intern este că CPU nu trebuie să efectueze o serie de procese pentru a accesa date de la o unitate la alta în cadrul unui computer.

Adică, pe viitor, aceleași protocoale care vor fi folosite la nivelul centrelor de date și al serverelor mari vor fi văzute pe PC-ul nostru pentru a nu doar intercomunica cu NVMe. SSD unități din ele, dar astfel încât fiecare element să poată fi comunicat diferit CPU. Vom renunța la acele protocoale precum cele utilizate în DirectStorage care vă oferă acces la SSD de la GPU fără a fi nevoie să treci prin procesor sunt bazate pe NVMe-oF.