Há alguns anos, quando a maioria de nós tinha monitores de resolução de 1024 x 768 ou até 1280 x 1024 pixels, os fabricantes nos diziam que parecia embaçado e que, para ter a melhor qualidade de imagem, precisávamos pular para Resolução Full HD (1920 x 1080). Agora que o 4K está na boca de todos, descobrimos que é Full HD que parece borrado e que precisamos comprar um monitor de alta resolução ter o melhor qualidade de imagem . Até que ponto isso é verdade?

Geralmente podemos pensar nisso como uma estratégia de marketing, e é exatamente isso: eles criaram monitores melhores e querem vendê-los, então eles nos dizem que o que temos agora não vale a pena e que precisamos gastar dinheiro com seu novo produto. Mas, na realidade, também estamos melhorando a qualidade da imagem… ou não?

Resolução mais alta significa melhor qualidade de imagem?

Se ficarmos com os dados empíricos, uma tela Full HD tem 1920 x 1080 pixels, ou o que é o mesmo, pouco mais de 2 milhões de pixels. Uma tela Ultra HD tem resolução de 3840 x 2160 pixels, cerca de 8.3 milhões de pixels, quatro vezes mais. Isso significa que no mesmo espaço estamos integrando muitos mais pixels, então o que teremos é um alta definição , enquanto estamos falando sobre o mesmo tamanho de tela.

E essa é uma informação importante, o tamanho da tela, porque o que nos dá definição não é a resolução ou o número de pixels, mas a densidade de pixels.

A densidade de pixels é o fator chave para definição

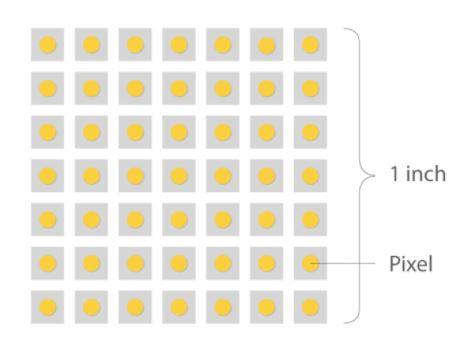

A densidade de pixels em um monitor é medida em pontos por polegada (DPI em inglês para "pontos por polegada"), mas uma vez que se refere ao número de pontos que estão dentro de uma linha de uma polegada de varredura, eles foram descontinuados em favor de PPI (pixels por polegada). Embora PPI seja o termo correto para se referir a monitores, os dois são freqüentemente usados de forma intercambiável.

A densidade de pixels é importante porque é o que determina a qualidade da imagem no sentido de que, em geral, uma densidade maior criará imagens mais nítidas. Vamos dar alguns exemplos tomando como referência um monitor de 27 polegadas, o que é bastante comum e normal hoje:

- Um monitor 27p de 720 polegadas teria cerca de 54 PPI.

- Um monitor 27p de 1080 polegadas tem uma densidade de cerca de 81 PPI.

- Se o monitor tiver resolução de 1440p, sua densidade será de cerca de 108 PPI.

- Se formos para a resolução 4K, a densidade sobe para 163 PPI.

- Um monitor 27K de 8 polegadas teria uma densidade de 326 PPI.

Para colocar esses dados em perspectiva, imagine que você tenha dois monitores, um ao lado do outro, e ambos com resolução Full HD. Se um deles tem o tamanho de 32 polegadas e o outro 27 polegadas, se você aumentar o zoom verá uma diferença óbvia em termos de tamanho dos pixels, pois embora os dois monitores tenham a mesma quantidade, a densidade dos 27 polegadas será muito maior, seus pixels serão menores e, portanto, fornecerá melhor definição.

Outro exemplo quando se trata de densidade: imagine um monitor 1000K de 4 polegadas (exagerando). Sendo assim, veremos que os pixels têm um tamanho considerável porque a densidade seria muito baixa e, portanto, a qualidade da imagem será ruim por mais 4K que seja.

Portanto, quanto maior a densidade de pixels, melhor?

A resposta é sim e não. Em geral, uma densidade de pixel mais alta é melhor porque fornece uma melhor definição de imagem, mas há um certo ponto onde o desempenho diminui. À medida que a densidade aumenta mais e mais, as vantagens observáveis dessa densidade mais alta são cada vez menos evidentes a ponto de serem imperceptíveis ao olho humano.

No exemplo acima, o monitor Full HD de 27 polegadas terá uma densidade de cerca de 81 PPI, enquanto o monitor de 32 polegadas terá 69 PPI. Nesta situação é seguro dizer que haverá diferenças observáveis entre os dois monitores, mas se estivéssemos falando de dois monitores de 24 polegadas, ambos, um com resolução de 4K e o outro de 8K, a diferença seria imperceptível, e ainda, obviamente, processar imagens em resolução de 8K tem um custo de desempenho muito maior do que fazer em 4K.

Nesse ponto, o ponto exato de densidade em que o olho humano para de perceber as mudanças está em debate. Alguns especialistas dizem que esse número é em torno de 400 PPI, outros dizem 1000, e a maioria dos usuários se contenta com menos de 200. Qualquer que seja esse ponto, o que é evidente é que chega um determinado momento. que uma densidade de pixels mais alta não é mais apreciada.

Qualidade da imagem, vinculada, mas não vinculada à resolução

Voltando ao tema principal, segundo Dolby, a qualidade da imagem que as pessoas percebem (porque afinal é uma questão subjetiva de percepção) depende principalmente de três fatores:

- O número de pixels (e sua densidade, como explicamos).

- A taxa de quadros por segundo.

- O desempenho dos pixels.

É neste último ponto que os fabricantes de painéis de monitores têm enfatizado nos últimos tempos, já que -de acordo com Dolby- se consegue que mesmo com o mesmo número de pixels estes sejam capazes de representar uma maior faixa dinâmica e com um maior espaço de cores , a qualidade de reprodução é melhorada. E no que nos diz respeito, não poderíamos estar mais de acordo, já que nem tudo é resolução quando falamos em qualidade de imagem mas em termos de experiência do usuário, FPS e tecnologias associadas, como HDR por exemplo, influenciam muito. .