Koncepcja lokalnego wykorzystania sztucznej inteligencji, szczególnie za pomocą narzędzi takich jak ChatGPT, zyskała ostatnio popularność zarówno wśród entuzjastów technologii, jak i profesjonalistów. Wybitnym przykładem tego trendu jest inicjatywa firmy StorageReview, która wykorzystała konfigurację NAS wzbogaconą o NVIDIA RTX A4000 do uruchomienia ChatGPT całkowicie offline.

Takie podejście podkreśla rosnące zainteresowanie zachowaniem prywatności i kontroli nad danymi przy jednoczesnym wykorzystaniu mocy sztucznej inteligencji.

Zalety wdrożenia lokalnej sztucznej inteligencji

1. Ulepszone Polityka prywatności oraz Bezpieczeństwo: Lokalne uruchomienie sztucznej inteligencji, takiej jak ChatGPT, na systemie NAS wyposażonym w solidny sprzęt gwarantuje, że wrażliwe dane pozostaną w granicach sieci prywatnej. Taka konfiguracja ogranicza ryzyko związane z naruszeniami danych i zagrożeniami zewnętrznymi, dzięki czemu jest szczególnie atrakcyjna dla środowisk, w których przetwarzane są wrażliwe lub poufne informacje.

2. Indywidualne rozwiązania AI: Wdrożenie lokalne pozwala na dostosowywanie i optymalizację narzędzi AI dostosowanych do konkretnych potrzeb organizacyjnych. Firmy mogą dostrajać swoje systemy sztucznej inteligencji bez polegania na usługach opartych na chmurze, co prowadzi do potencjalnie lepszej wydajności i integracji z istniejącą infrastrukturą IT.

3. Zmniejszone opóźnienia: Działając w sieci lokalnej, czas reakcji systemów AI jest znacznie skrócony, zapewniając szybszą i bardziej efektywną obsługę zapytań oraz przetwarzanie danych.

Jak firma StorageReview zbudowała lokalną sztuczną inteligencję

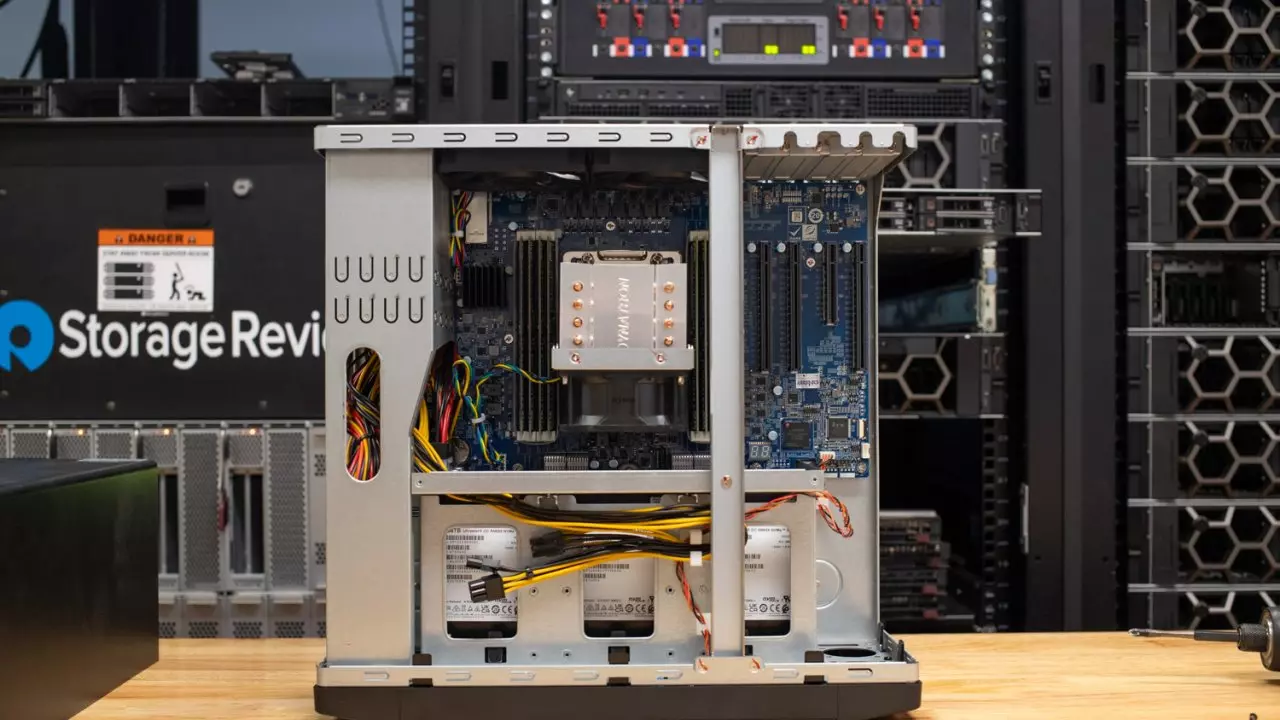

Projekt StorageReview obejmował serwer NAS QNAP-TS-h1290FX zasilany przez procesor AMD Procesor EPYC o pojemności 256 GB RAM i 12 gniazd NVMe. Ta wysokowydajna konfiguracja była kluczowa dla obsługi intensywnych wymagań obliczeniowych związanych z uruchamianiem sztucznej inteligencji, takiej jak ChatGPT.

Kluczowe było zastosowanie karty graficznej NVIDIA RTX A4000, profesjonalnej klasy wyposażonej w architekturę Ampere i umożliwiającej instalację w jednym gnieździe PCIe. Ten GPU obsługuje rozwiązanie NVIDIA „Chat with RTX”, umożliwiając serwerowi NAS lokalne uruchamianie ChatGPT ze znaczną mocą obliczeniową, dzięki rdzeniom Tensor.

Praktyczne zastosowania i dostępność

Ten typ konfiguracji sztucznej inteligencji jest odpowiedni nie tylko dla dużych korporacji, ale można go również wdrożyć w mniejszych firmach, a nawet w domu, pod warunkiem, że są wystarczające zasoby. Wymagania dotyczące replikacji takiej konfiguracji obejmują:

- Karta graficzna NVIDIA RTX z serii 30 lub 40 z co najmniej 8 GB pamięci VRAM.

- Co najmniej 16 GB pamięci RAM i system Windows 11.

- Minimum 35 GB wolnego miejsca na dysku.

Dla zainteresowanych dostępne jest do pobrania narzędzie NVIDIA „Czat z RTX”, które jest obecnie w początkowej fazie (wersja 0.2), oferując indywidualnym użytkownikom praktyczny sposób eksperymentowania i uczenia się podczas konfigurowania własnych lokalnych systemów AI.

Podsumowanie

Przejście w kierunku lokalnego wdrażania sztucznej inteligencji oznacza znaczącą zmianę w sposobie, w jaki postrzegamy i wykorzystujemy technologie sztucznej inteligencji. Hostując rozwiązania AI, takie jak ChatGPT, w sieciach prywatnych, organizacje mogą zapewnić większe bezpieczeństwo i dostosować rozwiązania do swoich konkretnych potrzeb, nie rezygnując przy tym z ogromnych korzyści płynących ze sztucznej inteligencji.

Tendencja ta nie tylko otwiera nowe możliwości w zakresie prywatności i bezpieczeństwa danych, ale także demokratyzuje dostęp do zaawansowanych możliwości sztucznej inteligencji, umożliwiając większej liczbie użytkowników odkrywanie potencjału technologii sztucznej inteligencji w ich własnych infrastrukturach.