Il y a quelques années, alors que la plupart d'entre nous possédaient des moniteurs de résolution 1024 x 768 ou même 1280 x 1024 pixels, les fabricants nous disaient que cela semblait flou et que pour avoir la meilleure qualité d'image, nous devions passer à Résolution Full HD (1920 x 1080). Maintenant que la 4K est sur toutes les lèvres, il s'avère que c'est la Full HD qui semble floue, et que nous devons acheter un moniteur de résolution plus élevée avoir le meilleure qualité d'image . Dans quelle mesure est-ce vrai?

Nous pouvons généralement considérer cela comme une stratégie de marketing, et c'est précisément cela: ils ont créé de meilleurs moniteurs et veulent les vendre, alors ils nous disent que ce que nous avons maintenant ne vaut pas la peine et que nous devons dépenser de l'argent. leur nouveau produit. Mais, en réalité, nous améliorons également la qualité de l'image… ou non?

Une résolution plus élevée signifie-t-elle une meilleure qualité d'image?

Si l'on s'en tient aux données empiriques, un écran Full HD a 1920 x 1080 pixels, ou ce qui est pareil, un peu plus de 2 millions de pixels. Un écran Ultra HD a une résolution de 3840 x 2160 pixels, soit environ 8.3 millions de pixels, quatre fois plus. Cela signifie que dans le même espace, nous intégrons beaucoup plus de pixels, donc nous aurons un définition plus élevée , tant que nous parlons de la même taille d'écran.

Et c'est une information importante, la taille de l'écran, car ce qui nous donne la définition n'est pas la résolution ou le nombre de pixels, mais la densité de pixels.

La densité de pixels est le facteur clé de la définition

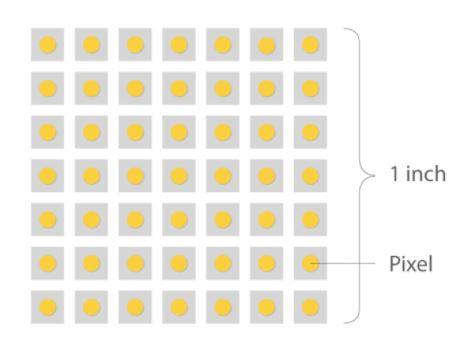

La densité de pixels dans un moniteur est mesurée en points par pouce (DPI en anglais pour «points par pouce») mais comme il s'agit du nombre de points qui se trouvent dans une ligne d'un pouce de numérisation, ils ont été abandonnés au profit de PPI (pixels par pouce). Bien que PPI soit le terme correct pour désigner les moniteurs, les deux sont souvent utilisés de manière interchangeable.

La densité de pixels est importante car c'est ce qui détermine la qualité de l'image dans le sens où, en général, une densité plus élevée créera des images plus nettes. Donnons quelques exemples en prenant comme référence un moniteur 27 pouces, ce qui est assez courant et normal aujourd'hui:

- Un moniteur 27p de 720 pouces aurait environ 54 PPI.

- Un moniteur 27 pouces 1080p a une densité d'environ 81 PPI.

- Si le moniteur a une résolution de 1440p, sa densité serait d'environ 108 PPI.

- Si on passe à la résolution 4K, la densité monte à 163 PPI.

- Un moniteur 27K de 8 pouces aurait une densité de 326 PPI.

Pour mettre ces données en perspective, imaginez que vous avez deux moniteurs, l'un à côté de l'autre, et les deux avec une résolution Full HD. Si l'un d'eux a une taille de 32 pouces tandis que l'autre mesure 27 pouces, si vous zoomez, vous verrez une différence évidente en termes de taille des pixels, car bien que les deux moniteurs aient la même quantité, la densité des 27 pouces seront beaucoup plus grands, ses pixels seront plus petits et offriront donc une meilleure définition.

Autre exemple en matière de densité: imaginez un moniteur 1000K de 4 pouces (exagérant). Cela étant, nous verrons que les pixels ont une taille considérable car la densité serait très faible, et donc la qualité de l'image sera mauvaise quelle que soit la 4K.

Donc, plus la densité de pixels est élevée, mieux c'est?

La réponse est oui et non. En général, une densité de pixels plus élevée est meilleure car elle offre une meilleure définition d'image, mais il y a un certain point où les performances diminuent. À mesure que la densité augmente de plus en plus, les avantages observables de cette densité plus élevée sont de moins en moins évidents au point qu'ils sont imperceptibles à l'œil humain.

Dans l'exemple ci-dessus, le moniteur Full HD de 27 pouces aura une densité d'environ 81 PPI, tandis que le moniteur de 32 pouces aura 69 PPI. Dans cette situation, il est prudent de dire qu'il y aura des différences observables entre les deux moniteurs, mais si nous parlions de deux moniteurs 24 pouces, les deux, l'un avec une résolution 4K et l'autre 8K, la différence serait imperceptible, et pourtant, de toute évidence, le traitement d'images à une résolution de 8K a un coût de performance beaucoup plus élevé que de le faire à 4K.

À ce stade, le point exact de densité auquel l'œil humain cesse de percevoir les changements est sujet à débat. Certains experts disent que ce chiffre est d'environ 400 PPI, d'autres disent 1000, et la plupart des utilisateurs se contentent même de moins de 200. Quoi qu'il en soit, ce qui est évident, c'est qu'il arrive un certain point dans le temps. qu'une densité de pixels plus élevée n'est plus appréciée.

Qualité d'image, liée mais non liée à la résolution

Pour revenir au sujet principal, selon Dolby, la qualité d'image que les gens perçoivent (car après tout c'est une question de perception subjective) dépend principalement de trois facteurs:

- Le nombre de pixels (et leur densité, comme nous l'avons expliqué).

- Le taux d'images par seconde.

- La performance des pixels.

C'est sur ce dernier point que les fabricants de panneaux de moniteurs ont mis l'accent ces derniers temps, car -selon Dolby- si l'on parvient à ce que même avec le même nombre de pixels ceux-ci soient capables de représenter une plus grande plage dynamique et avec un espace colorimétrique plus grand. , la qualité de reproduction est améliorée. Et en ce qui nous concerne, nous ne saurions être plus d'accord, car tout n'est pas résolution quand on parle de qualité d'image mais en termes d'expérience utilisateur, les FPS et les technologies associées, comme le HDR par exemple, ont une grande influence. .