Petit à petit l'abandon du disque est un fait et l'utilisation des disques SSD se développe de plus en plus. Cependant, ce changement ne se produit pas seulement dans le monde des ordinateurs personnels, mais également dans celui des serveurs. Le protocole NVMe-oF a beaucoup à voir avec tout cela. Que signifient ces acronymes et pourquoi peuvent-ils façonner l'avenir du stockage sur PC ?

La transition progressive vers l'utilisation des SSD NVMe pour le stockage dans tous les secteurs de l'informatique se poursuit de manière régulière, déterministe et sans freins. Cela inclut les systèmes de réseau, qui intercommuniquent aujourd'hui plusieurs ordinateurs entre eux, soit sur un réseau local, soit dans un centre de données.

La plupart des unités de stockage sont du type DAS ou Direct Access Storage dans lequel seul le PC sur lequel ladite unité est installée peut accéder à son contenu et, par conséquent, dans un environnement réseau, il est nécessaire de développer des protocoles qui, par exemple, dans un environnement de centre de données ou un supercalculateur composé de dizaines ou de centaines de disques permettent d'accéder à l'ensemble de l'infrastructure de stockage.

Comment se passe la communication dans un data center ?

Avant d'aborder le fonctionnement de NVMe-oF et en quoi il consiste. Il faut garder à l'esprit que les technologies utilisées dans un centre de données ou un réseau local pour faire intercommuniquer son stockage interne sont appelées SAN, qui signifie Zone de stockage Réseau ou stockage en réseau local. Pour cela, trois technologies différentes sont aujourd'hui utilisées, toutes basées sur le vétéran SCSI.

- Protocole Fibre Channel (FCP) : il est un protocole qui transporte Commandes SCSI via un réseau à fibre optique , bien que cela puisse également être fait sur des lignes de cuivre. Leurs débits peuvent aller de 1 à 128 Go/s.

- iSCSI : Qu'est-ce qui combine le Protocole Internet TCP/IP et commandes SCSI . Ceci est basé sur des cartes réseau conventionnelles et est conçu pour les réseaux à très faible bande passante car il est limité à leurs capacités Ethernet. Donc des vitesses de 1 GB / s sont courants, même si 10 GB / s commencent à se voir ces derniers temps.

- SCSI attaché en série : le plus utilisé de tous et basé sur câbles SAS qui permettent de connecter jusqu'à 128 unités de stockage via des adaptateurs de bus hôte ou des HBA. La vitesse de ceux-ci peut être de 3 Go/s, 6 Go/s, 12 Go/s et même 22.5 Go/s.

Cependant, toutes ces technologies sont destinées à communiquer avec des disques durs conventionnels. Et nous devons supposer que l'accès à un disque dur est différent de celui d'un lecteur flash. Ce qui fait que l'utilisation de ces protocoles n'est pas la plus appropriée.

Qu'est-ce que NVMe-oF ?

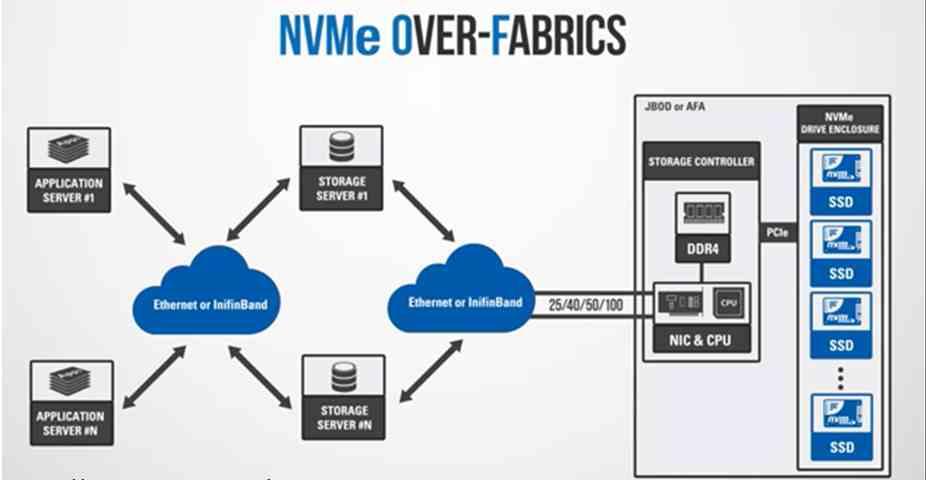

Eh bien, ils sont l'acronyme de NVMe over Fabric et c'est que ce protocole n'était pas seulement prévu pour communiquer avec des unités de mémoire flash ou non volatiles, mais aussi pour l'intercommunication des différents éléments d'un système via des infrastructures d'intercommunication. Nous devons comprendre que nous nous référons à une structure de communication entre deux éléments. Qui peut être deux processeurs, un RAM et un processeur, un accélérateur et une mémoire ROM, etc. N'oublions pas que les topologies utilisées pour ce cas utilisent les mêmes structures qu'en télécommunications, mais à très petite échelle.

Cependant, cela va être utilisé pour communiquer les SSD NVMe sur le réseau. Soit pour communiquer différents éléments au Processeur au sein du même PC ou à défaut via une carte réseau. On parle donc de grands centres de données. L'avantage d'utiliser NVMe-oF ? Eh bien, par rapport aux protocoles SATA et SAS utilisés dans les disques durs, ceux-ci sont capables de prendre en charge une file d'attente allant jusqu'à 65,000 65,000 requêtes de bout en bout et jusqu'à XNUMX XNUMX commandes différentes par requête , par rapport à une seule requête sur 1 et moins de 256 commandes. . Ce qui est essentiel dans les environnements avec de plus en plus de cœurs faisant des demandes de données au stockage qui pourraient saturer le réseau.

Types de NVMe-OF

Il existe actuellement deux variantes, qui sont les suivantes :

- NVMe-of avec canal fibre optique : qui a été conçu pour s'intégrer dans les centres de données et les serveurs existants en prenant en charge les anciens protocoles tels que SCSI. Cela facilitera la transition vers l'utilisation de lecteurs flash dans les centres de données et les serveurs existants.

- NVMe via Ethernet : qui est utilisé par deux ordinateurs pour échanger des données via accès direct à la mémoire à distance (RDMA) et, par conséquent, fait référence au fait que deux ordinateurs peuvent échanger le contenu de leurs mémoires flash dans des SSD NVMe sans que le processeur de l'un ou l'autre système n'intervienne dans le processus. Dans ce cas, la communication n'utilise pas les paquets dits SCSI.

N'oublions pas que les mémoires Flash NAND sont également appelées RAM non volatile en raison du fait que leur nature lors de leur accès est la même que celle de la RAM, seulement qu'elles ne perdent pas d'informations lorsqu'elles cessent de recevoir une charge électrique. Ceci permet le déploiement de technologies permettant d'intercommuniquer deux mémoires RAM distinctes pour le faire avec les différentes mémoires flash.

De quelles vitesses parle-t-on ?

N'oublions pas que les SSD NVMe utilisent des interfaces PCI Express, donc la version basée sur la fibre optique sera l'un des candidats possibles pour connecter les différents SSD NVMe au sein de l'infrastructure d'un centre de données ou d'un réseau local. Cependant, Ethernet continuera à dominer en tant que protocole de communication standard pour les réseaux pendant encore longtemps. Il ne fait aucun doute que les interfaces réseau à des vitesses de 50, 100 et même 200 Gigabits par seconde sont en cours de développement et seront bientôt déployés dans les centres de données.

L'avenir de NVMe-oF est aussi sur PC

Le RDMA intégré dans NVMe-oF n'est pas une nouvelle technologie, car il a été mis en œuvre dans des marchés de niche pendant des années, en raison du fait que les contrôleurs de réseau intégrés ou NIC avec RDMA étaient très coûteux et nécessitaient des techniciens hautement spécialisés pour leur maintenance. sa mise en œuvre était coûteuse. Cependant, il sera essentiel à l'avenir, même sur les ordinateurs de bureau. La raison en est que les infrastructures internes des processeurs évoluent vers ce que nous appelons NoC. En eux, chaque élément du processeur possède une petite carte réseau intégrée et une adresse IP avec laquelle communiquer avec le reste des éléments via ce que nous pourrions appeler un processeur réseau intégré au processeur.

Ce n'est un secret pour personne connaissant le sujet que de la même manière que les contrôleurs de réseau ont été vus intégrés dans les CPU, la prochaine étape consiste à le faire avec les contrôleurs flash trouvés dans les SSD NVMe. De plus, l'avantage d'implémenter NVMe-oF en interne est que le CPU n'a pas à exécuter une série de processus pour accéder aux données d'une unité à une autre au sein d'un ordinateur.

C'est-à-dire qu'à l'avenir, les mêmes protocoles qui seront utilisés au niveau des centres de données et des gros serveurs se verront sur notre PC afin non seulement d'intercommuniquer avec le NVMe SSD unités en leur sein, mais de sorte que chaque élément puisse être communiqué différemment au CPU. Nous allons simplement laisser tomber les protocoles comme ceux utilisés dans DirectStorage qui vous donnent accès au SSD depuis le GPU sans avoir à passer par le processeur sont basés sur NVMe-oF.