La bataille sur le marché des cartes graphiques entre AMD et NVIDIA existe depuis plusieurs années maintenant, mais AMD n'a pas toujours fabriqué de cartes graphiques et son origine est dans une société appelée ATI Technologies, qui est à l'origine du groupe Radeon Technology. Rejoignez-nous dans ce voyage où nous allons vous raconter l'histoire d'AMD GPU division.

La division GPU d'AMD est née en 1985 sous le nom d'Array Technology Incorporated, la société spécialisée depuis le début dans la création de puces graphiques à utiliser dans les cartes graphiques pour PC, un marché né à cette époque dans le but de fournir des solutions plus bon marché pour Normes IBM ou pour proposer les vôtres.

Solution graphique ATI Rev 3

À l'aube du PC, vous pouviez utiliser des moniteurs basés sur des téléviseurs, qui n'avaient pas de récepteur radio pour afficher le contenu de la télévision, ou un écran monochrome de résolution plus élevée. Dans les bureaux du monde entier, le second type était plus largement utilisé car il permettait de travailler avec 80 caractères par ligne de texte contre les 40 caractères du moniteur dérivés de la télévision.

Mais une alternative à l'option IBM appelée Hercules est apparue, qui autorisait également jusqu'à 80 colonnes, mais de 9 caractères chacune. Cela permettait également un mode monochrome avec une mémoire tampon d'image de 720 x 350 pixels, mais nécessitait une carte graphique spéciale, ce qui signifiait une perte de compatibilité avec la carte IBM MDA.

La solution graphique ATI Rev 3 est devenue très célèbre lorsqu'elle est apparue sur le marché en 1985, intégrant une carte graphique CGA et un Hercules en une seule unité. En raison de cette polyvalence, il est devenu très célèbre à l'époque, car il évitait l'utilisation de plusieurs types de cartes graphiques dans un PC en fonction du type de moniteur.

Cartes graphiques ATI Wonder

ATI a commencé à se faire un nom grâce à son EGA Wonder, une carte graphique sous la norme EGA qui combinait le chipset Graphics Solution Rev 3 avec une puce EGA de Chips Technologies, afin que cette carte puisse gérer diverses normes graphiques sans avoir à avoir plusieurs adaptateurs. , qui a donné une énorme compatibilité face à l'énorme confusion des normes graphiques PC.

La carte a été remplacée par l'ATI VGA Wonder, qui comprenait un chipset VGA développé par ATI lui-même et maintenait la compatibilité avec le reste des normes précédentes également sur une seule carte.

Cartes graphiques ATI Mach

En 1990, ATI a continué à faire des clones de normes IBM, avec l'ATI Mach 8 ils ont fait un clone de la puce graphique IBM 8514 / A, qui était le début de la norme XGA, cette norme permettait une résolution d'écran de 1024 × 768 pixels, avec une palette de 256 couleurs, ou 640 × 480 avec 16 bits par pixel (65,536 XNUMX couleurs) et a essayé de copier certaines des fonctionnalités graphiques de la puce graphique Commodore AMIGA.

L'un des avantages de l'AMIGA par rapport au PC était le soi-disant Blitter, une unité matérielle qui permettait de copier des données d'une partie de la mémoire à une autre, en manipulant les données à la volée grâce à des opérations booléennes. Cela a permis à l'AMIGA avec un processeur moins puissant d'avoir des applications de dessin puissantes.

La particularité de ce standard est qu'il est né comme une extension parallèle du VGA pour les moniteurs professionnels. Son plus grand avantage? C'était l'ajout d'opérations graphiques de style Blitter comme celles que l'on trouve dans le Commodore Amiga. Ainsi, des opérations visuelles telles que dessiner des lignes, copier des blocs ou remplir la couleur d'une forme ont fini par être possibles sans avoir à utiliser Processeur cycles pour cela.

Une fois que les normes graphiques pré-VGA étaient complètement obsolètes, ATI a publié l'ATI Mach 32, qui comprenait un noyau VGA, unifiant ainsi les séries ATI Wonder et ATI Mach en une seule, bien qu'ATI ait continué à utiliser le nom ATI Wonder pour certains produits. . en dehors de sa gamme principale de cartes graphiques, telles que les décodeurs vidéo, qui étaient utilisés à cette époque pour décoder des fichiers vidéo sur CD.

En commençant par l'ATI MACH64, ils ont unifié le chipset VGA et le MACH en un seul processeur graphique.

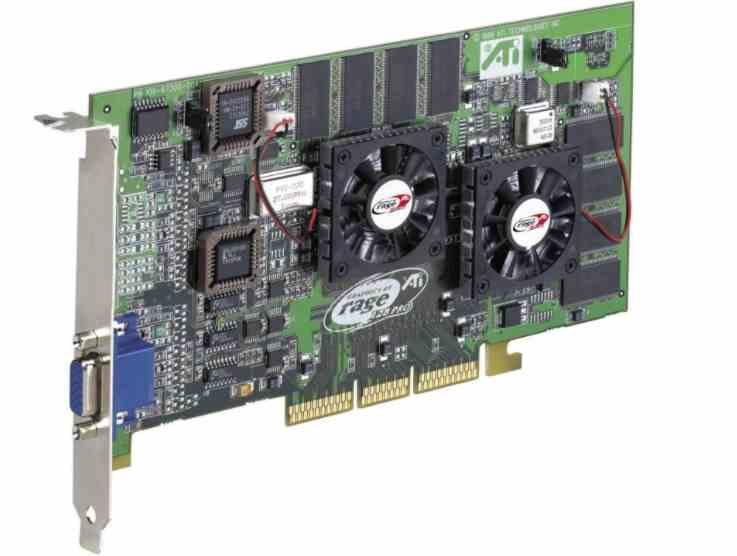

Cartes graphiques ATI RAGE

L'énorme succès du Voodoo Graphics de 3Dfx et l'apparition de jeux basés sur des graphismes 3D en temps réel ont poussé des entreprises comme ATI à se rattraper pour ne pas disparaître du marché des cartes graphiques, leur réponse était l'ATI Rage.

Le problème avec la plupart des cartes graphiques est que les processeurs, depuis la standardisation du Intel Pentium dans les maisons, rend les scènes de jeu 3D beaucoup plus rapides que les cartes graphiques à l'époque. puis, qui avait été conçu pour fonctionner avec le 486 et allait donc s'emballer.

La solution d'ATI était de modifier son chipset ATI MACH64 pour apporter une série de changements qui rendraient sa gamme de cartes graphiques compétitive pour un avenir de jeu 3D avec des graphiques en temps réel.

- La possibilité de traiter les textures et de les filtrer a été ajoutée, pour cela un cache de texture de 4 Ko a été ajouté.

- Une configuration Triangle ou une unité de rastérisation a été ajoutée, pour soulager le processeur d'une telle charge lourde.

Cependant, le premier ATI Rage est arrivé en retard et bien qu'ils aient la puissance d'un Voodoo Graphics, pâlissent contre le Voodoo 2 et le Riva TNT, la réponse d'ATI n'était autre que d'augmenter le nombre d'unités de texture de 1 à 2 et de mettre un 128 bits. bus, qu'ils ont vendu sous le nom d'ATI Rage 128.

Une autre carte qui s'est démarquée au sein de la gamme ATI Rage était la FURY MAXX, qui était la première carte graphique ATI à implémenter ce qui à l'avenir finirait par être la technologie Crossfire, ce qui a permis à ATI de placer deux puces Rage 128 dans une carte.

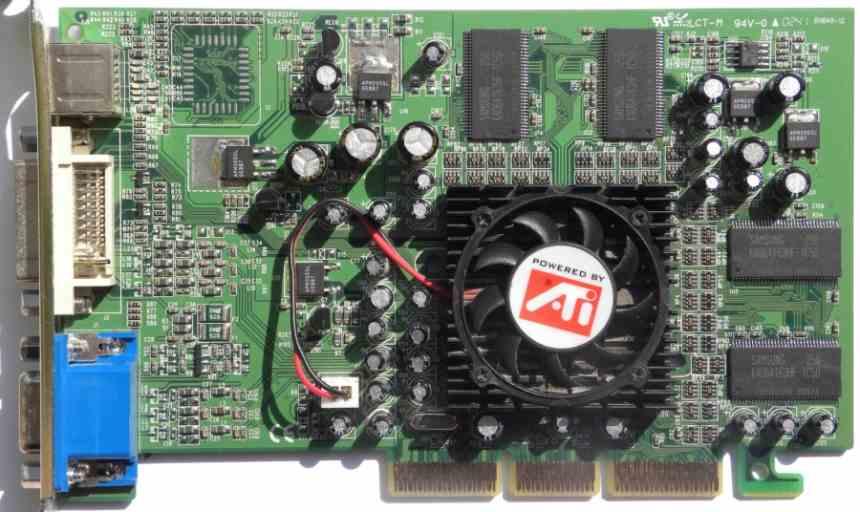

Le premier des graphiques ATI Radeon

ATI a abandonné la marque Rage en commençant par la première Radeon, qui était la première carte de support DirectX 7 de la société. Il utilisait le GPU ATI R100 qui avait initialement été nommé Rage 7, en réalité ce n'était rien de plus qu'un Rage 128 avec une unité T&L intégrée et c'est que le support complet de DirectX 7, impliquait la mise en œuvre d'unités qui calculent le géométrie de la scène lors du rendu des scènes 3D en temps réel.

Ainsi, la Radeon 7500 dans l'âme n'était rien de plus qu'une Rage 128 avec les unités de fonction fixes pour le calcul de la géométrie. Elle n'avait pas les mêmes performances que les GeForces de première et deuxième génération qui sont sorties au même moment, mais c'était le point tournant de l'entreprise pour faire le changement nécessaire.

Mais ce qui a laissé ATI devenir le rival de NVIDIA pendant des années, la raison en était la disparition et l'achat ultérieur de 3Dfx par NVIDIA et l'effondrement de S3 et Matrox avec des cartes graphiques qui n'étaient pas disponibles. la hauteur.

L'achat d'ArtX par ATI

Les technologies ATI des années 2000 doivent beaucoup à l'achat d'une petite société d'anciens ingénieurs Silicon Graphics appelée ArtX. Quand ATI l'a acheté, son travail le plus récent était la puce graphique pour le Nintendo Console GameCube, bien qu'ils aient déjà travaillé sur Nintendo 64 et certains de ses ingénieurs sur le légendaire Silicon Graphics Reality Engine.

L'achat était important car son capital humain et son savoir-faire ont complètement transformé ATI, ce qui a permis de se regarder face à NVIDIA. Paradoxalement, malgré le fait qu'ATI Technologies n'ait jamais conçu de GPU pour console Nintendo, l'achat d'ArtX a fait apparaître son logo sur les consoles Nintendo dotées des technologies ArtX, GameCube et Wii.

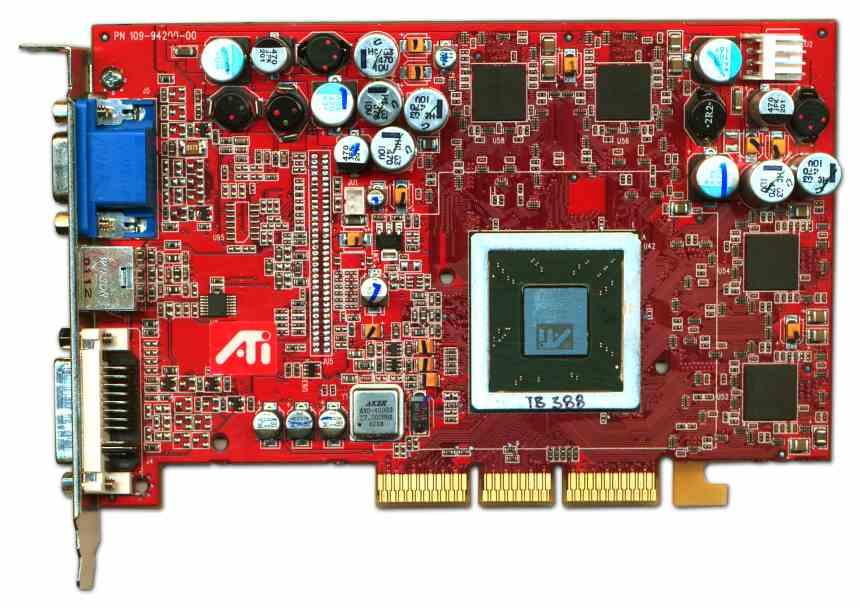

Radeon 9700, le début de l'âge d'or

L'ATI Radeon 9700 sous le chipset R300 est devenue l'une des cartes graphiques les plus importantes de l'histoire d'ATI, sinon la plus importante de toutes, et équivaut à la première NVIDIA GeForce en termes d'impact.

Afin d'être compétitif, AMD a racheté la startup ArtX, fondée par les mêmes anciens ingénieurs de Silicon Graphics qui avaient travaillé sur la technologie 3D des consoles Nintendo64 et Nintendo GameCube. Le résultat de l'achat? Le GPU R300, avec lequel ATI était à l'avant-garde.

De plus, ils ont eu la tempête parfaite, puisque le lancement de la Radeon 9700 a coïncidé avec le plus gros dérapage de NVIDIA de toute son histoire, le GeForce FX, la légende de l'ATI Radeon avait commencé et la rivalité entre NVIDIA et ATI a commencé à partir de là. point dans l'histoire.

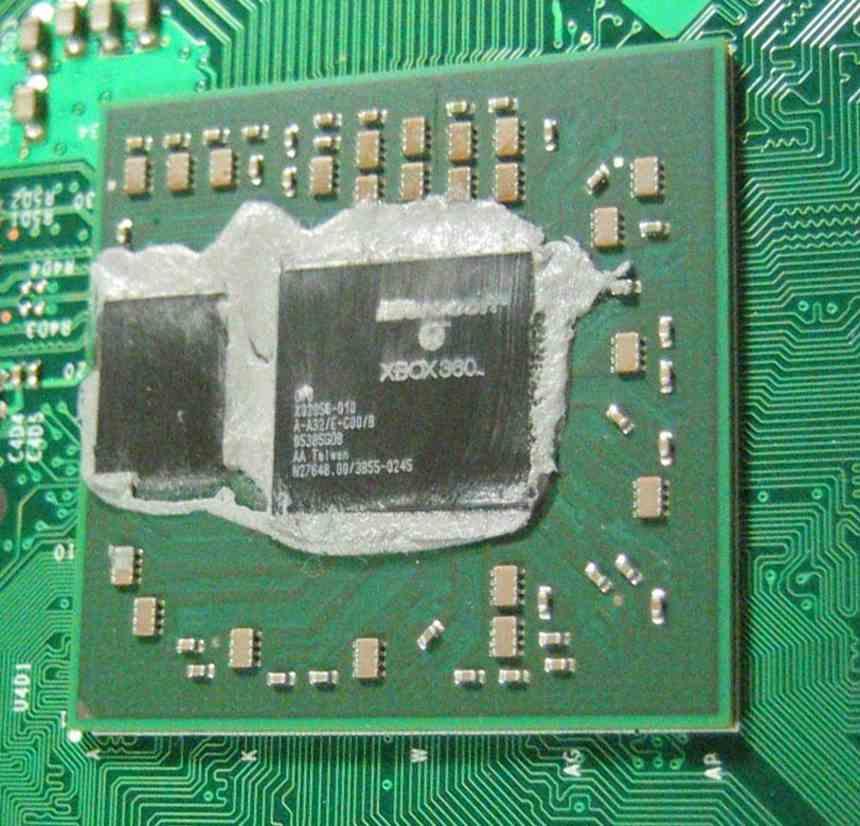

Xenos, le premier GPU console d'ATI

Initialement Microsoft allait lancer ce qui allait être Windows Vista en 2003 ou 2004 sous le nom de code Longhorn et avec elle une nouvelle version de son DirectX, 10, qui n'était pas celle qui a finalement été sortie pour PC mais une version plus recadrée qui n'apparaissait pas à la fin et pour laquelle ATI Technologies a conçu un GPU, qui a été le premier à avoir la même unité pour exécuter les différents types de shader.

Lorsque Windows Longhorn n'est pas sorti, le nom de code de Vista à ce moment-là. ATI et Microsoft ont décidé de le repositionner en tant que ATI Xenos de Xbox 360. Être le premier design ATI dans une console de jeu vidéo et ouvrir une collaboration entre ATI et Microsoft, qui fait maintenant partie d'AMD, qui dure encore aujourd'hui avec la série Xbox. Et aussi obtenir une future collaboration avec SONY pour le PlayStation. C'est pour tout cela qu'il s'agit de l'une des puces graphiques les plus importantes de l'histoire d'ATI.

ATI Radeon HD 2000

La première carte graphique ATI avec des shaders PC unifiés est apparue plus tard que la GeForce 8800, bien qu'elle ait été mise en œuvre par ATI pour la première fois de l'histoire avec le GPU Xbox 360.

Cependant, l'architecture était complètement différente et vous ne pouvez pas comparer le GPU de la console Microsoft avec l'architecture de la R600, qui, dans sa version la plus puissante, la Radeon HD 2900 avait environ 320 ALU, qui sous l'architecture Terascale est de 64 unités VLIW5 et donc 4 unités de calcul.

Cependant, les GPU ATI R600 sur lesquels reposait la Radeon HD 2000 ont été une déception, car ils n'ont pas été en mesure de rivaliser avec la NVIDIA GeForce GTX 8800. Un an plus tard, ATI a lancé la série HD . 3000 sous le nœud 55nm et polissant certains défauts de conception de l'architecture R600, en particulier son anneau de communication interne.

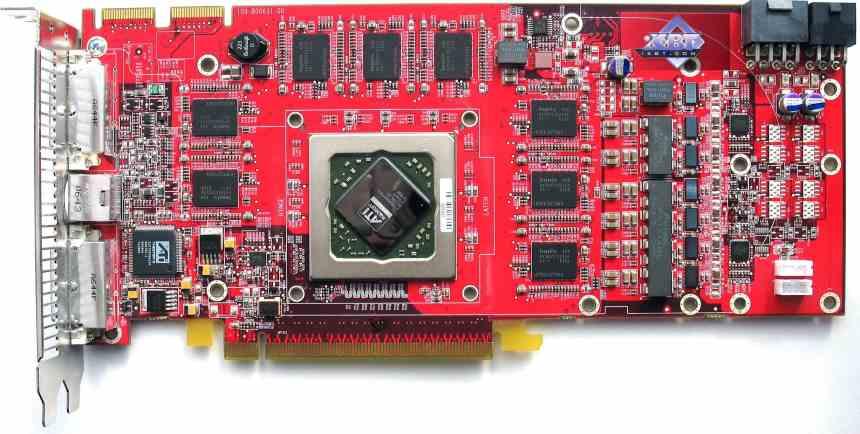

ATI Radeon HD 4870

Suite au fiasco des variantes d'architecture R600, AMD a décidé de faire passer l'architecture R600 de 320 ALUS à 800 ALU, créant ainsi l'architecture R700 qui a commencé avec l'ATI Radeon HD 4000 que l'ATI Radeon HD 4870 est devenue. chez la reine absolue, ATI avait de nouveau regagné le trône en termes de performances et était à nouveau confrontée à une concurrence directe.

ATI Radeon HD 5000

Au lieu de concevoir une architecture complètement nouvelle pour DirectX 11, chez ATI, ils ont décidé de publier le chipset R800, qui était un R700, mais optimisé et amélioré pour DirectX 11, eh bien, il n'était pas réellement optimisé pour DirectX 11, mais ATI Je publie Terascale 2 comme un moyen de sortir de la route et avec très peu de changements vraiment.

L'une des nouveautés de DirectX 11 était Compute Shaders, mais au départ, elle a été soulevée en unifiant la liste du dessin à l'écran et de l'informatique en une seule. Ce fut un énorme désastre pour ATI et NVIDIA, mais ATI à l'époque était plutôt concentré sur la possibilité de rendre possible l'idée d'AMD, dont il faisait déjà partie, d'unir CPU et GPU sur une seule puce. Tous ses efforts se sont donc concentrés sur le projet AMD Fusion.

La série ATI Technologies 5000 était la fin de la marque ATI dans les cartes graphiques, qui a été rebaptisée par la suite en Radeon Technology Group ou RTG et continue à ce jour.