Viele Male hören wir in letzter Zeit, vor allem aufgrund der Verwendung von ARM Architektur von Apple und Intel Foveros, über die big.LITTLE Architektur in Prozessoren, in denen „kleine“ Kerne mit geringem Verbrauch nebeneinander für die leichtesten Aufgaben vorhanden sind und „große“ Kerne, um die gesamte Leistung freizusetzen. Im Moment haben wir diese Architektur nur in CPUs gesehen, aber wäre es möglich, sie auch in zu implementieren GPUs für Grafikkarten ?

Das Konzept dieser Architektur ist sehr einfach und gleichzeitig effektiv: Wir haben einen Chip mit zwei Arten von Kernen, einige kleine, die immer aktiv sind und sich um leichte Aufgaben wie das Surfen im Internet oder das Schreiben in Word kümmern andere Größere und leistungsstärkere Kerne, die normalerweise ausgeschaltet sind und auf eine Aufgabe warten, die erforderlich ist mehr Macht rennen um aufzuwachen und zu übernehmen. Diese big.LITTLE-Architektur wird in Prozessoren verwendet, bei denen die Kernanzahl relativ niedrig ist, insbesondere im Vergleich zu a GPU, Wobei Die Anzahl der Kerne liegt bei Tausenden .

NVIDIA Optimus war schon eine Art Big.LITTLE auf GPU

Viele von Ihnen werden sich an die Tage erinnern, als fast alle Laptops mit einer dedizierten GPU hatten NVIDIA Optimus-Technologie. Diese Technologie bedeutete, dass wenn wir am Schreibtisch saßen oder Aufgaben erledigten, die nicht 3D waren, die im Prozessor integrierte Grafikkarte verwendet wurde, um Energie zu sparen. Wenn wir jedoch ein Spiel oder eine 3D-Aufgabe ausführten, wurde die dedizierte Grafik verwendet, um dies zu können habe die ganze Kraft zur Verfügung.

Diese clevere Art, die Tatsache auszunutzen, dass das Notebook zwei GPUs hatte, ist im Wesentlichen eine Art groß. KLEIN, aber im groben Modus (anstatt eine ganze Architektur zu sein), aber die Idee ist im Grunde die gleiche: wenn die GPU wird nicht benötigt „groß“ ist aus und im Standby-Modus, wobei die iGPU die gesamte Arbeit erledigt, solange dies möglich ist, Strom spart und die erzeugte Wärme reduziert. Bei Bedarf startet die „große“ GPU und liefert Spitzenleistung.

Kann es also implementiert werden?

Natürlich ist die Idee sehr gut, aber entweder integrieren sie zwei GPUs auf derselben Platine für dieselbe Funktionalität, über die wir zuvor gesprochen haben, oder die Dinge werden ziemlich kompliziert, und es ist nicht dasselbe, mit den 4-16 Kernen a zu arbeiten CPU kann als mit den mehreren tausend GPUs haben (um dies in Zusammenhang zu bringen, eine Radeon RX 6800 XT hat 3,840 Shader-Prozessoren (Kerne), während eine RTX 3090 satte 10,496 CUDA-Kerne hat).

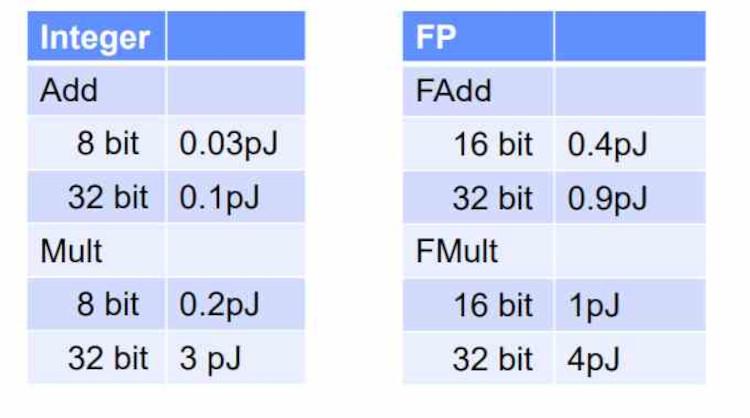

Für eine vollständige Implementierung dieser Architektur müsste die Funktionsweise der GPU neu definiert werden, da derzeit bereits zwei Arten von ALUs vorhanden sind: Eine wird für einfache Anweisungen verwendet und deren Verbrauch ist sehr gering, während andere (SFUs) dafür verantwortlich sind zum Ausführen komplexerer Operationen wie Quadratwurzeln, Logarithmen, Potenzen und trigonometrischen Operationen. Sie sind nicht groß. KLEINE Kernel, aber genau aus diesem Grund werden sie bereits anders genannt (FP32-ALUs).

Sie sehen also, sowohl in der Vergangenheit mit Optimus als auch heute etwas Ähnliches wie big.LITTLe ist bereits in der GPU implementiert. Was passiert, ist, dass es offensichtlich anders ist, anders funktioniert und nicht so heißt. Da jedoch in letzter Zeit alles auf eine höhere Effizienz beim Verbrauch ausgerichtet zu sein scheint, können wir dies nicht ausschließen, und natürlich sowohl NVIDIA als auch NVIDIA AMD das Potenzial haben, es auszuführen. Es wäre natürlich eine ideale Situation, um Energie zu sparen und weniger Wärme zu erzeugen, oder?