Der er mange tjenester og værktøjer, vi har til rådighed, når det kommer til at udnytte de online platforme og enheder, som vi bruger. Når du surfer på Internettet, er det ofte nødvendigt at indhente visse data og oplysninger. Vi kan gøre brug af det, der er kendt som web skrabning . I denne artikel vil vi forklare, hvad den består af, og vi vil også give nogle muligheder for det.

Hvad er webskrabning

Med webskrabning, eller også kendt som webskrabning , vi henviser til den metode, hvormed vi kan udtrække information fra websteder. Til dette bruges software, der endda kan simulere en brugers normale navigation, men automatisere processen.

Vi kan relatere webskrabning til indeksering af et websted i søgemaskiner. I dette tilfælde er det nu mere fokuseret på at omdanne ustrukturerede data på nettet (for eksempel HTML-format) til strukturerede data, der kan lagres og analyseres i en database eller et regneark.

For emnet for webpositionering, denne teknik er blevet udbredt i de senere år. Det tjener også til at sammenligne priser i onlinebutikker, dataovervågning osv. Mange brugere er afhængige af denne funktion for at skabe kvalitetsindhold.

Kort sagt kan vi sige, at web-skrabning består af udtrække information fra en webside. Noget, vi kan gøre på brugerniveau manuelt, men at vi også kan bruge computerprogrammer til det.

Skrabning af webprogrammer for at udtrække information

Vi vil se nogle gratis programmer, som vi kan bruge til at indsamle oplysninger fra en webside.

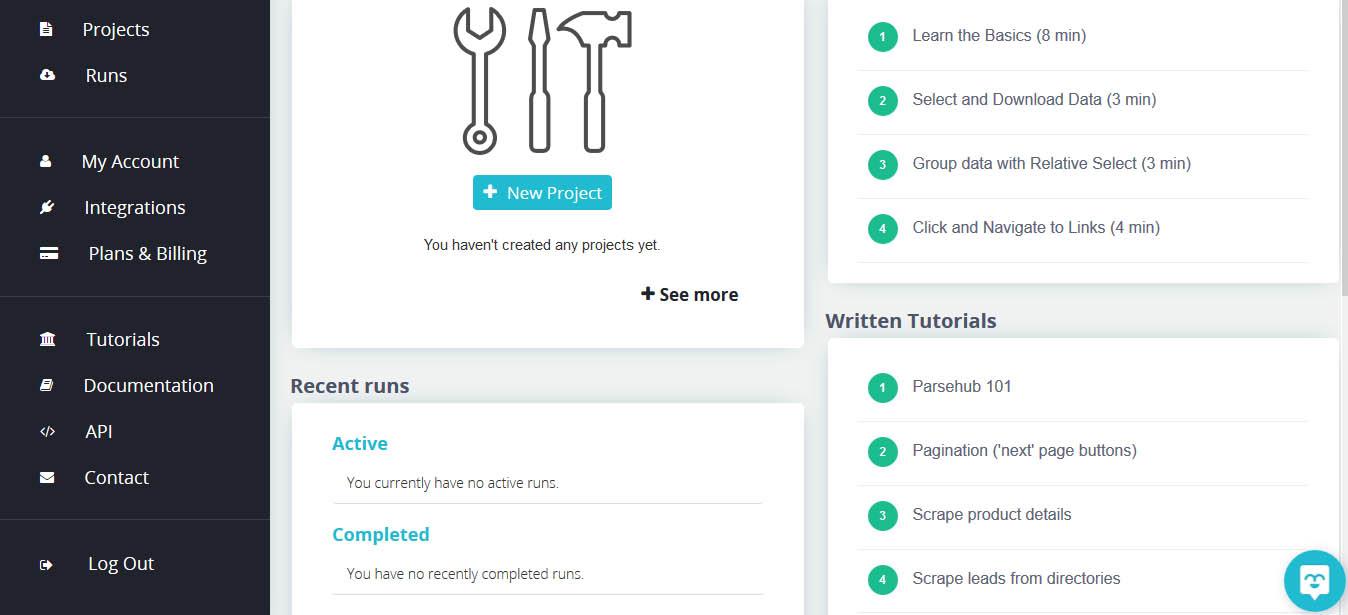

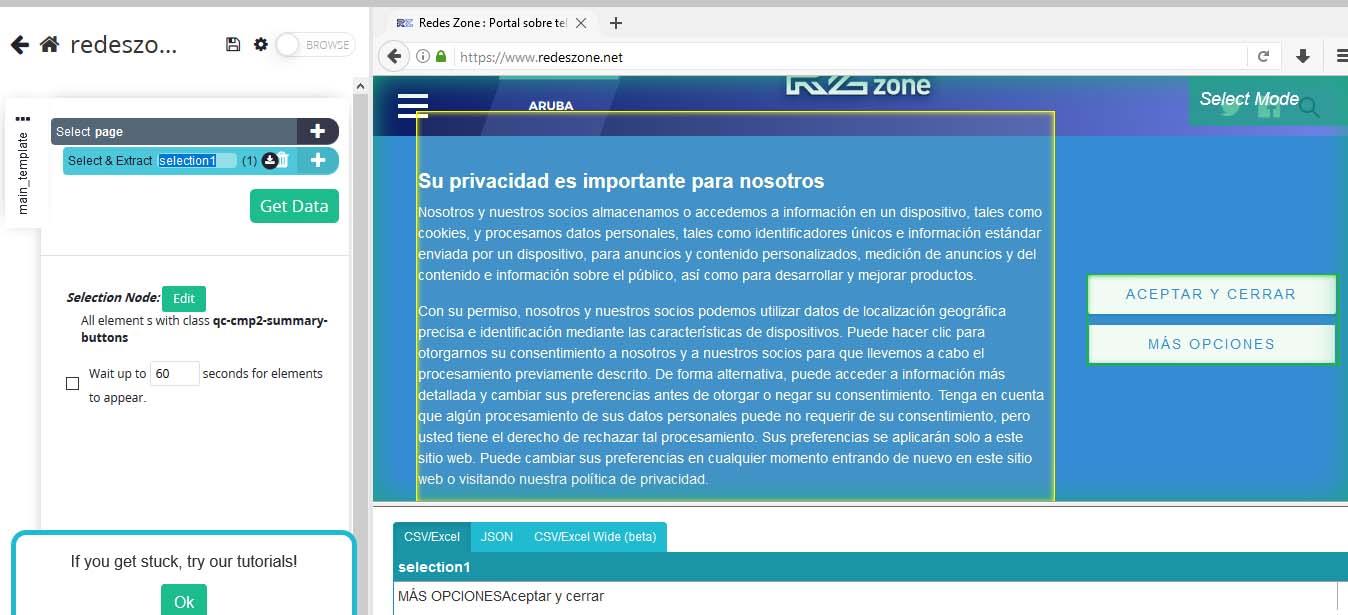

Parsehub

Et af de værktøjer, vi har til rådighed, er det Parsehub . Det er et desktop-program, der giver dig mulighed for at oprette forbindelse til ethvert websted, hvorfra vi ønsker at udtrække data. Det har en pæn grænseflade og er også nem at bruge. Vi kan eksportere dataene i forskellige formater som f.eks JSON, CSV eller Excel .

Den første ting, vi skal gøre for at begynde at bruge Parsehub er at downloade det fra dets websted. Vi vil se, at den er tilgængelig til Windows, Linux og macOS. Når vi har downloadet det, er det næste trin at installere det. Når vi har udført det, vil det bede os om at oprette en konto.

Når vi åbner det, vises et vindue som det, vi ser på billedet ovenfor. Senere bliver vi nødt til at oprette et nyt projekt og skrive den adresse, hvorfra vi er interesseret i at udtrække data for at komme i gang.

Skrabere

En anden mulighed, vi har til at indsamle oplysninger fra et websted, er Skrabere . I dette tilfælde er det en webværktøj , også gratis, der giver dig mulighed for at udføre denne handling på en enkel og intuitiv måde. De udpakkede data kan eksporteres i JSON, HTML og CSV.

Når vi går ind på dit websted, ser vi, at det er nødvendigt at registrere dig for at bruge tjenesten. Derfra bliver vi nødt til at oprette en ny skraber, lægge de nødvendige data og give dem til at starte. Det begynder at indsamle oplysninger fra dette websted.

Skrabhund

Et lignende alternativ til det foregående er Skrabhund . Vi kan teste din gratis prøveversion. Vi bliver nødt til at registrere endnu en gang. Til en grundlæggende brug er denne gratis version nok. Den har også en betalt adgang til via en proxy og være i stand til at udtrække data fra mere komplekse websteder.

Som i de tidligere tilfælde bliver vi nødt til at gøre det sæt URL'en der interesserer os og begynder at udtrække information fra dette websted.

Dexi.io

Dexi har en simpel grænseflade, der giver os mulighed for det udtræk data i realtid fra enhver webside, der bruger den indbyggede maskinlæringsteknologi. Det giver mulighed for at udtrække både tekster og billeder. Det er baseret på en cloud-løsning og tillader eksport af udpakkede data til platforme som Google Sheets, Amazon S3 og andre lignende.

Ud over at udtrække data med Dexi vi kan også overvåge i realtid. Det har værktøjer til at holde os opdateret om alle de ændringer, der kan forekomme på et bestemt sted. En måde at få større viden også om konkurrencen i tilfælde af f.eks. At have en side til at sælge produkter online. Det har en gratis mulighed til grundlæggende brug, men det har også andre betalte muligheder.

Kort sagt, dette er nogle muligheder, vi har til at udføre webskrabning. Vi har set nogle enkle programmer, der kan være nyttige for dem, der har brug for at udtrække information fra websteder.