Grafikhardware er mildest talt komplekst, da når vi går for at købe en, finder vi en liste over funktioner på grafikkortet og akronymer, der trækker de nyere brugere tilbage og derfor med mindre viden. Hvis dette er dit tilfælde, skal du ikke bekymre dig om det, da vi i denne artikel vil lære dig at læse alle disse egenskaber som ekspert.

Processen med at samle en PC for første gang fra vores side er et arbejde, der rækker ud over at samle brikkerne, det består også i at vælge dem, der passer. På grund af den kontinuerlige udgivelseskadence finder vi i butikker med grafikkort af forskellige generationer og til samme pris. Så slutbrugeren uden viden kan finde en dårligere specifikation efter at have betalt det samme.

Derfor er det nødvendigt at vide, hvad egenskaberne ved et grafikkort betyder, før du foretager dit køb, for at vide, om det er det, vi har brug for,

Modeller

En måde at identificere et grafikkort på er gennem den model det er, med dette kan vi vide, om vi står over for en top af rækken inden for dens generation eller en anden med mere beskedne specifikationer.

AMD

Hvis vores GPU er fra AMD så skal vi kigge efter dem, der starter som RX, og kassere meget gamle modeller, der har akronymer som R9, R7. Og ja, hvis du ikke vidste det, står forkortelsen RX for R10, men AMD beholdt navnet af markedsføringsmæssige årsager. Den næste ting du vil se er 3 figurer, hvis du er mellem en, der har en GPU med GCN-arkitektur eller 4 figurer, hvis det er RDNA, sidstnævnte er bedre i specifikationer, og i tilfælde af RX 6 × 00 vil du have DirectX 12 Ultimativ support.

Med hensyn til den anden figur, mærket i hvilket område grafikkortet er, så vil en RX 6900 være bedre end en RX 6800, som samtidig vil have bedre egenskaber end en RX 6700. Som afslutning kan du finde XT-modeller, disse er noget bedre specifikationer.

NVIDIA

I det tilfælde, at dine GPU'er er fra NVIDIA, hvis du vil have et grafikkort, der er opdateret, skal du kigge efter et, der starter med initialerne RTX i stedet for GTX, da dette vil sikre, at du har fuld understøttelse af DirectX 12 Ultimate. Hvad angår det firecifrede tal, angiver de to første generationen, og det vokser med tiere. Så en RTX 30 × 0 vil være af en mere avanceret generation end en RTX 20.

De sidste to figurer angiver det område, som det tilhører, og derfor styrken inden for den samme arkitektur. Så RTX 3090 er mere kraftfuld end RTX 3080. Fra tid til anden udgiver NVIDIA Ti-modeller, der har bedre specifikationer end normale modeller, og udgiver også ofte revisioner efter et stykke tid, der får SUPER-efternavnet.

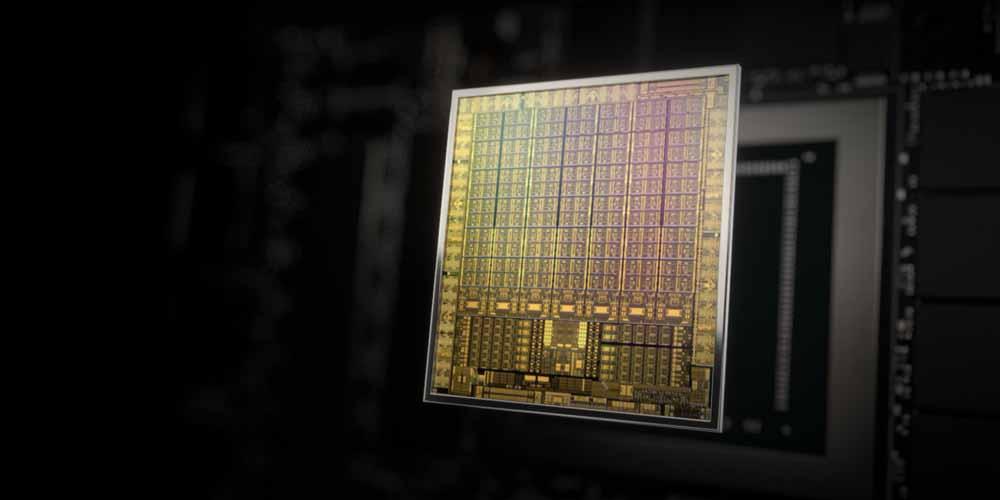

GPU'en og dens funktioner

I midten af grafikkortet er et komplekst stykke hardware, som vi kender som GPU eller Graphical Processing Unit, en grafisk behandlingsenhed, og som er ansvarlig for at generere de scener, der vises på din skærm i videohukommelsen eller VRAM, som omgiver. Slutningen af processen er at sende det nævnte billede til skærmen, så vores øjne kan se det, og dette gøres flere dusin gange i sekundet.

I dag er GPU'er stykker hardware, der har et kompleksitetsniveau i deres arkitektur på niveau med en central processor eller CPUDet er dog ikke nødvendigt at kende alle grafikkortets egenskaber ved køb. På den anden side bruges udtrykket også ofte til at tale om hele den grafiske hardware, hvilket fører til forvirring på trods af, at dette stykke hardware ikke kan fungere uden resten af de elementer, der omgiver det.

GPU arkitektur

Med arkitektur refererer vi til de omgivende elementer af samme og den måde, hvorpå de er fordelt. Forklaringen er så enkel, som at mere avancerede arkitekturer tillader tilføjelse af nye visuelle muligheder, højere ydeevne i højere opløsningstilstand eller højere hastigheder, når man spiller vores yndlingsspil.

Både AMD, NVIDIA og Intel med hver ny arkitektur forbedre specifikationerne for de tidligere. I tilfældet med Intel, da ARC Alchemist er dets første dedikerede grafikkort, er det ikke en forvirring, til gengæld er der i tilfælde af NVIDIA og AMD dukket flere generationer af grafikkort op i de senere år.

Derudover er navnet på den grafiske arkitektur ikke det samme som det kommercielle navn på grafikkortet, derfor vil du mange gange finde visse grafikkort, der ikke er nævnt ved boksens navn, men med deres arkitektur. På samme måde kan vi også se, hvad GPU'ens arkitektur er ved at se på silketryk på dens indkapsling, i hvert fald i tilfældet med NVIDIA's.

Størrelse

Fordi ikke alle har den samme skærm, eller budget, og ikke de samme behov, inden for den samme GPU-arkitektur, lanceres flere modeller i form af forskellige chips. Hvordan adskiller disse sig? Nå, i nøglepunkter som:

- interface med videohukommelsen og derfor båndbredden med det og videohukommelsen i alt. Husk, at jo flere båndbredde, du kan tilslutte flere VRAM-chips. En god måde at se, om et grafikkort har en lavere ende end et andet, er ud fra mængden af hukommelse omkring GPU'en.

- Mængden af behandlingsenheder inde i GPU'en , som det er indlysende, jo mindre plads inde i chippen, mindre plads kan placeres inde i den, og dette har en effekt på at have mindre computerkraft.

Alle GPU'er inden for den samme arkitektur, på trods af at de har forskellige størrelser, deler alle de fælles elementer, der definerer det, men på forskellige effektniveauer. Det faktum, at en model har en GPU-størrelse og mindre hukommelse end en anden, udmønter sig også i en prisklasse for alle behov.

Shader-enheder og "kerner"

En marketing faldgrube, som grafikkortproducenter udfører, er at kalde det, der er 32-bit floating-point computerenheder som kerner. Realistisk set er en kerne minimumsenheden, der kan udføre en komplet instruktion i et program, så en udførelsesenhed, der kun er en del af kernen, kan ikke betragtes som en kerne i sig selv.

Shader-enheder i AMDs tilfælde kaldes Compute Units eller Workgroup Processors afhængigt af den arkitektur vi taler om, i stedet har NVIDIA brugt udtrykket Streaming Multiprocessors eller SM i nogen tid. Men når de taler om kerner i deres specifikationer, refererer de generelt til enheder, der er i stand til at udføre 32-bit flydende aritmetiske beregninger under navnet CUDA, NVIDIA eller Stream Processors, AMD-kerner.

Faktisk, da disse beregningsenheder er inden for, hvad der er shader-enheder, betyder det faktum, at en GPU har flere CUDA-kerner eller flere Stream-processorer, at den er mere kraftfuld end en anden, der har færre.

GPU clockhastigheder

I grafikkortets karakteristika vil du finde forskellige clockhastigheder, som GPU'en kan nå på bestemte tidspunkter. Det skal tages i betragtning, at det meste af tiden vil GPU'en forblive på en relativt lav clockhastighed for at forbruge så lidt som muligt, ikke generere varme og ikke tænde for ventilatorerne til dets kølesystem.

Men når vi starter en grafisk tung applikation, såsom gengivelse af en 3D-scene med Blender, eller når vi spiller et videospil, vil den starte med dens basis-urhastighed, der er markeret i dens specifikationer, så din systemkøling starter op, og GPU'en vil fungere hele tiden på den frekvens, i hvert fald indtil vi har brug for det.

I nogle konfigurationer forbliver grafikkortet i dvale, da CPU'en normalt indeholder en integreret GPU indeni for funktioner så enkle som at flytte Windows skrivebordet.

Boost frekvens

I nogle GPU'er vil du se en højere clockhastighed, dette er Boost-frekvensen, som fungerer på samme måde som i en CPU. Så i en begrænset periode vil urhastigheden stige for at fremskynde gengivelsen af scenen eller for at foretage de nødvendige beregninger så hurtigt som muligt. Boost-frekvensen kan dog ikke nås længe, da jo højere forbrug, jo mere temperatur frigives, og det er farligt for GPU'en på lang sigt. I tilfældet med AMD-modeller er der en lettere Boost-frekvens kaldet Game Clock, som har en længere varighed i tid, da den ikke er så stor en stigning som Boost.

Mange producenter, når de giver tallene for deres tekniske specifikationer, bruger hastighedshastighederne fra Boost-frekvensen, som om den var aktiv hele tiden. Selvom det er rigtigt, at en sådan ydeevne kan opnås, kan dette kun gøres midlertidigt.

Faste funktionsenheder

De kaldes sådan på grund af, at de altid udfører den samme funktion, så den er ikke programmerbar, men er fast 100% af tiden. Funktionen af disse enheder er at udføre en række processer, der gentages kontinuerligt i hvert billede, når en scene gengives rekursivt.

Fyldhastighed og teksturering

Fyldhastighed er antallet af pixels, som en GPU skriver til videohukommelsen for at skabe rammen over den. Dette falder ikke sammen med dem, der sendes til skærmen, da en pixel i VRAM på grund af den måde, en 3D-scene genereres på, kan skrives flere gange. Til dette bruges en type enhed kaldet ROPS, Raster Outputs, som modtager den allerede behandlede pixel og kopierer den ind i videohukommelsen.

Tekstureringshastighed har på den anden side at gøre med teksturenheder, og de arbejder omvendt. Mens ROPS'en skriver til hukommelsen, læser teksturenheden fra VRAM'ens lagrede teksturkort for at kende basisfarveværdien for den pixel i det pågældende objekt.

Fyldhastigheden aflæses i pixels pr. sekund, mens tekstureringshastigheden aflæses i texel pr. sekund. Ledsaget af et bogstav foran udtrykket, hvor M står for millioner og G for milliarder.

Styrken i funktionerne på et grafikkort

Den mest almindelige måde at repræsentere en GPU's computerkraft på er gennem antallet af 32-bit flydende kommaoperationer, den kan udføre. Nå, i virkeligheden er det ikke sådan, da vi taler om hastigheden opnået på tidspunktet for udførelse af en komplet instruktion, der er additionen med multiplikation eller FMA, der består af to operationer pr. clock-cyklus.

Så hvordan beregnes computerkraft? Nå, meget simpelt, med følgende formel:

Urhastighed * antal beregningsenheder eller Stream Multiprocessing * CUDA-kerner eller Stream-processorer pr. enhed * 2 = FP32-computerkraft.

At være den mest forenklede form:

Urhastighed * CUDA-kerner eller Stream-processorer pr. enhed på tværs af hele GPU'en * 2 = FP32-computerkraft.

Løsning

Et andet af karakteristikaene ved et grafikkort, som vi er nødt til at se på, er den understøttede målopløsning, på niveau med bevægelige desktopapplikationer kan enhver GPU flytte dem uden problemer, men med hensyn til spil er det anderledes, og vi finder, at inden for hver arkitektur disse fordeles i henhold til den opløsning, de er beregnet til.

I øjeblikket er de avancerede til 4K og derfor en opløsning på 3840 x 2160 pixels, mellemområdet er QHD med 1440p opløsning og for at afslutte den lave ende er i Full HD eller 1080p. I hvert område fordobles den kraft, der kræves for at gengive kvasi, men i virkeligheden er dette ikke tilfældet, og i dag er low-end-kort mere parate til at flytte scener i Full HD end high-end-kort, dem med fire gange opløsningen.

Et grafikkorts VRAM og dets egenskaber

VRAM er den hukommelse, som GPU'en bruger til at arbejde, det er en lokal type, og derfor er den generelt uden for CPU'ens rækkevidde. Det vil sige, at det ikke kan bruges af pc'ens centrale processor til at udføre programmer, og at tilføje mere VRAM gennem grafikkortet betyder derfor ikke at udvide RAM systemets hukommelse.

I øjeblikket er der to typer VRAM-hukommelse, som vi kan finde i et grafikkorts egenskaber. På den ene side GDDR, hvor de allerede er i sjette generation og har en form for flere chips monteret på samme board som GPU'en. Den anden type VRAM, som vi har, er HBM'en, som kan identificeres ved at være monteret på GPU'en på en lille base, som vi kalder interposer, som er placeret over kortpladen.

På grund af specifikationerne for begge typer videohukommelse, kan vi finde dem på forskellige markeder, i øjeblikket er GDDR5, GDDR6 og GDDR6X de mest almindelige på hjemmemarkedet og HBM2 grafikkorthukommelser til meget mere professionelle miljøer.

VRAM båndbredde

Hvis vi har en hukommelse af GDDR-typen, skal vi tælle antallet af chips i grafikkortet og gange dem med 32 for at finde ud af antallet af datastifter mellem VRAM'en og GPU'en. Kun de ensidige, da der er mulighed for at få to hukommelseschips til at dele en grænseflade. Det er tilfældet med RTX 3090 Ti, som har 24 hukommelseschips, men kun 384 busbit, 12 gange 32 bit. I tilfælde af, at vi har en HBM-hukommelse, vil vi tælle antallet af chips og gange dem med 1024.

Det andet punkt er at se på mængden af Gbps af hukommelsesspecifikationer, dette er mængden af information målt i bits per sekund, ikke bytes, der transmitteres på et sekund for hver datapin. Så for at have båndbredden på VRAM'en skal vi kun gange Gbps med det tal, du tidligere har opnået.

Da GPU'er er processorer, der er afhængige af datagennemstrømning for deres ydeevne, betyder lavere båndbredde på én model med den samme GPU sammenlignet med en anden lavere ydeevne.

Mængden af VRAM-hukommelse

Den sidste ting, vi skal vide, er lagerkapaciteten på video-RAM, i øjeblikket er den mest brugte hukommelse GDDR6, som kan have 1 eller 2 GB kapacitet chips. I pc er det ikke normalt at se asymmetriske konfigurationer af chips i kapacitet, så et grafikkort med 8 hukommelseschips kan have 8 GB eller 16 GB. På den anden side, i modsætning til grænsefladen, tæller GDDR6-chippene på begge sider, når det kommer til at opnå kapaciteten.

Hvad angår HBM-hukommelsen, er hver chip flere hukommelser stablet og samlet som én, så du bør se på specifikationerne for mængden af tilgængelig hukommelse.

Andre funktioner ved et grafikkort

Udover GPU'en og videohukommelsen er der andre egenskaber ved et grafikkort, som vi ikke bør overse og derfor også er vigtige.

PCI Express

Grafikkortene er forbundet til pc'en ved hjælp af det 16-benede PCI Express-interface, som tillader kommunikation mellem og resten af pc'en, specifikt med systemets CPU og RAM. Men på trods af, at stikket er generaliseret i form, er nye versioner af standarden dukket op med stigende hastighed. Så hvis du skal købe et grafikkort med PCI Express 4.0 interface og din bundkort understøtter en 3.0-type, vil du være i stand til at bruge den, men du vil miste ydeevne ved ikke at have nok båndbredde til kommunikation.

Understøttelsen af en eller anden version af PCI Express-standarden hjælper os også med at markere alderen på et grafikkort frem for et andet, så husk denne detalje, så du ikke får et forældet grafikkort i dets specifikationer.

Fodring

Grafikkort kræver elektrisk strøm for at fungere, og PCI Express-porten kan levere op til 75W strøm. Der er dog grafikkort, der har brug for ekstra strøm for at fungere og som regel kommer med et ekstra stik, der giver det ekstra strøm udover det, som kommunikationsgrænsefladen giver. Det 6-benede stik har kapacitet til at levere 75 W ekstra strøm, det 8-benede 150 W.

Nogle grafikkort har et 12-bens stik, som kan give op til 500 W ekstra strøm til en GPU og overskride grænsen på 375 W. Under alle omstændigheder, jo mere forbrug end mere strøm, så det er en måde for brugernes niveauer at vide, om de står over for et grafikkort med avancerede specifikationer eller ej.

Videoudgange

Et grafikkort skal sende de billeder, det skaber, til skærmen, men ikke alle grafikkort har videoudgange, og selvom dette kan resultere i en modsigelse, er det i virkeligheden ikke det, da der er grafikkort, hvis specifikationer kan ses, de ikke gør. har videoudgange, det skyldes, at de bruges til videnskabelig databehandling eller minedrift.

De mest brugte videoudgange i dag er HDMI og DisplayPort, så hvis du står med et grafikkort med DVI- eller VGA-udgange, vil det vise, at du står over for en meget gammel model, og at den derfor ikke vil nå minimumsspecifikationerne. Dette sker normalt ikke, men pas på, at de ikke belaster dig i den forbindelse.